El sexismo en los algoritmos: una discriminaci¨®n subestimada

IBM predice que solo la inteligencia artificial que est¨¦ libre de sesgos sobrevivir¨¢

A pesar del auge del feminismo en los ¨²ltimos a?os, los efectos negativos y generalizados del sexismo en la inteligencia artificial suelen ser subestimados.

Lejos de ser minoritario, el sexismo, y la discriminaci¨®n que este genera, impregna hoy en d¨ªa el funcionamiento de los algoritmos de inteligencia artificial. Esto es un problema porque cada vez usamos m¨¢s algoritmos para tomar decisiones cruciales sobre nuestras vidas. Por ejemplo, qui¨¦n puede acceder y qui¨¦n no a una entrevista de trabajo o a una hipoteca.

Sexismo en los algoritmos

La literatura cient¨ªfica que estudia la presencia de sesgos y errores en los algoritmos de aprendizaje autom¨¢tico est¨¢ todav¨ªa en sus primeras etapas, pero los resultados son muy preocupantes.

Se ha comprobado que los algoritmos heredan los sesgos de g¨¦nero que imperan en nuestra sociedad. Como veremos a continuaci¨®n, los sesgos humanos llevan a errores sistem¨¢ticos en los algoritmos. Es m¨¢s, a menudo estos sesgos tienden a incrementarse debido a la gran cantidad de datos que manejan los algoritmos y a su uso generalizado.

Por ejemplo, en un estudio en el que se aplicaron t¨¦cnicas de aprendizaje autom¨¢tico para entrenar a una inteligencia artificial utilizando Google News, se resolvi¨® la analog¨ªa ¡°hombre es a programador de ordenadores lo que mujer es a x¡±. La respuesta autom¨¢tica fue que ¡°x = ama de casa¡±.

De manera similar, otro hallazgo inquietante fue el que se observ¨® en un algoritmo entrenado con texto tomado de Internet. Este asociaba nombres femeninos como Sarah con palabras atribuidas a la familia, tales como padres y boda. En cambio, nombres masculinos como John ten¨ªan asociaciones m¨¢s fuertes con palabras atribuidas al trabajo, como profesional y?salario.

Amazon tambi¨¦n tuvo que eliminar su algoritmo de selecci¨®n de personal porque mostraba un fuerte sesgo de g¨¦nero, penalizando los CV que conten¨ªan la palabra mujer.

El sexismo tambi¨¦n se cuela en los algoritmos de b¨²squeda de im¨¢genes. Por ejemplo, una investigaci¨®n mostr¨® que en Bing se recuperan fotos de mujeres m¨¢s a menudo al utilizar en las b¨²squedas palabras con rasgos c¨¢lidos, como por ejemplo, sensible o emocional. Por el contrario, palabras con rasgos de competencia, tales como inteligente o racional, est¨¢n m¨¢s representados por fotos de hombres. Es m¨¢s, al buscar la palabra persona se recuperan m¨¢s a menudo fotos de hombres que de mujeres.

En otro trabajo se observ¨® que el algoritmo asociaba im¨¢genes de compras y cocinas con mujeres. As¨ª, deduc¨ªa que ¡°si est¨¢ en la cocina, es mujer¡± la mayor parte de las veces. En cambio, asociaba im¨¢genes de entrenamiento f¨ªsico con hombres.

Adem¨¢s de los datos de texto y las im¨¢genes, las entradas e interacciones que realizan los usuarios tambi¨¦n refuerzan y nutren el aprendizaje de sesgos de los algoritmos. Un ejemplo de ello lo confirm¨® un trabajo en el que se observaba que los temas relacionados con la familia y las relaciones rom¨¢nticas se discuten mucho m¨¢s frecuentemente en los art¨ªculos de Wikipedia sobre las mujeres que sobre los hombres. Adem¨¢s, las biograf¨ªas de mujeres tienden a estar m¨¢s vinculadas (mediante enlaces) a la de los hombres que viceversa.

Sesgo algor¨ªtmico en lenguas con g¨¦nero

Los estudios que se han centrado en examinar el sesgo de g¨¦nero lo han hecho casi exclusivamente analizando el funcionamiento de los algoritmos con el idioma ingl¨¦s. Sin embargo, esta lengua no tiene g¨¦nero gramatical.

En ingl¨¦s, la maestra simp¨¢tica y el maestro simp¨¢tico se dice igual: the nice teacher. Por tanto, cabe preguntarse qu¨¦ ocurre con lenguas como el espa?ol, que s¨ª tiene g¨¦nero gramatical.

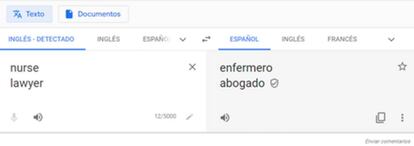

La investigaci¨®n al respecto ha encontrado sesgos de g¨¦nero al traducir del ingl¨¦s a idiomas con g¨¦nero gramatical como el nuestro. Por ejemplo, un estudio mostr¨® que al traducir la palabra lawyer del ingl¨¦s al espa?ol hab¨ªa una asociaci¨®n autom¨¢tica m¨¢s fuerte con la palabra abogado que abogada. Por el contrario, la palabra nurse estaba m¨¢s relacionada con la palabra enfermera que enfermero. En principio tendr¨ªa que haber asociado ambas traducciones con id¨¦ntica probabilidad.

A pesar de las numerosas cr¨ªticas de los ¨²ltimos a?os, los sesgos que se producen al traducir desde una lengua sin g¨¦nero gramatical, como el ingl¨¦s, a una con g¨¦nero gramatical, como el espa?ol, se siguen dando hoy en d¨ªa en algunos traductores autom¨¢ticos como, por ejemplo, DeepL (ver Figura 1).

Algunos traductores como Google Translate han introducido correcciones. Hoy en d¨ªa traducen con el masculino gen¨¦rico un conjunto de palabras (ver Figura 2), pero han incorporado tambi¨¦n el desdoblamiento por g¨¦nero femenino y masculino de palabras e incluso frases cortas (ver Figura 3).

?Qu¨¦ soluci¨®n tiene?

En la actualidad, se est¨¢n desarrollando iniciativas y est¨¢ndares destinados a abordar el problema de los sesgos algor¨ªtmicos. Pero, por el momento, la mayor parte de los sistemas de inteligencia artificial presenta sesgos.

La investigaci¨®n sugiere que subestimamos los sesgos presentes en las m¨¢quinas e incluso tendemos a considerar m¨¢s justas y preferir las recomendaciones de los algoritmos a las de los humanos. Pero, ?realmente queremos delegar nuestras decisiones en algoritmos que asocian mujer con ama de casa? IBM predice que ¡°solo la inteligencia artificial que est¨¦ libre de sesgos sobrevivir¨¢¡±.

?Qu¨¦ soluci¨®n tiene?

En la actualidad, se est¨¢n desarrollando iniciativas y est¨¢ndares destinados a abordar el problema de los sesgos algor¨ªtmicos. Pero, por el momento, la mayor parte de los sistemas de inteligencia artificial presenta sesgos.

La investigaci¨®n sugiere que subestimamos los sesgos presentes en las m¨¢quinas e incluso tendemos a considerar m¨¢s justas y preferir las recomendaciones de los algoritmos a las de los humanos. Pero, ?realmente queremos delegar nuestras decisiones en algoritmos que asocian mujer con ama de casa? IBM predice que ¡°solo la inteligencia artificial que est¨¦ libre de sesgos sobrevivir¨¢¡±.

Naroa Martinez es investigadora Posdoctoral, Universidad de Deusto y Helena Matute es catedr¨¢tica de Psicolog¨ªa en la misma universidad.

Este art¨ªculo fue publicado originalmente en The Conversation.

Tu suscripci¨®n se est¨¢ usando en otro dispositivo

?Quieres a?adir otro usuario a tu suscripci¨®n?

Si contin¨²as leyendo en este dispositivo, no se podr¨¢ leer en el otro.

FlechaTu suscripci¨®n se est¨¢ usando en otro dispositivo y solo puedes acceder a EL PA?S desde un dispositivo a la vez.

Si quieres compartir tu cuenta, cambia tu suscripci¨®n a la modalidad Premium, as¨ª podr¨¢s a?adir otro usuario. Cada uno acceder¨¢ con su propia cuenta de email, lo que os permitir¨¢ personalizar vuestra experiencia en EL PA?S.

?Tienes una suscripci¨®n de empresa? Accede aqu¨ª para contratar m¨¢s cuentas.

En el caso de no saber qui¨¦n est¨¢ usando tu cuenta, te recomendamos cambiar tu contrase?a aqu¨ª.

Si decides continuar compartiendo tu cuenta, este mensaje se mostrar¨¢ en tu dispositivo y en el de la otra persona que est¨¢ usando tu cuenta de forma indefinida, afectando a tu experiencia de lectura. Puedes consultar aqu¨ª los t¨¦rminos y condiciones de la suscripci¨®n digital.