El o¨ªdo musical de las m¨¢quinas recorta la distancia que le separa de la visi¨®n artificial

Etiquetado autom¨¢tico de canciones y separaci¨®n de voz e instrumentos son algunas de las aplicaciones del campo, que comienza a salir de la sombra de sectores m¨¢s populares

¡°Por desgracia, y por decirlo en pocas palabras, el campo de la inteligencia artificial (IA) tiende a sobresimplificarse de la siguiente manera: IA es igual a deep learning, que es igual a visi¨®n artificial¡±. Son palabras escritas por el investigador en Ingenier¨ªa de Sonido Jordi Pons en su tesis, que acaba de ser reconocida con uno de los premios de investigaci¨®n inform¨¢tica SCIE-Fundaci¨®n BBVA, en la categor¨ªa de investigadores j¨®venes inform¨¢ticos. Ese esquema, marcado por las ramas de investigaci¨®n m¨¢s populares, dejaba fuera el sonido y los consiguientes avances en escucha artificial (machine listening), al menos hasta hace poco. ¡°Aunque las tecnolog¨ªas no son a¨²n perfectas, ya nos permiten hacer algunas cosas que antes se consideraban imposibles¡±, se?ala Pons.

Entre los hitos conquistados figuran las investigaciones de este ingeniero en materia de etiquetado autom¨¢tico de canciones, el tema central de su tesis. ¡°Es una forma de estructurar bases de datos de tal manera que puedes clasificar grandes colecciones para hacer recomendaciones o b¨²squedas¡±, explica. Otra l¨ªnea de trabajo de Pons es la separaci¨®n de fuentes, que permite descomponer una canci¨®n en los sonidos que la componen, por ejemplo, haciendo sonar por un lado la voz de Paul McCartney y por otro su piano mientras los Beatles interpretan Let It Be. ¡°Por primera vez se pueden comercializar autokaraokes, por ejemplo. Que parece una tonter¨ªa, pero en Jap¨®n hay muchos aficionados a este entretenimiento. O igual sacar un solo de bater¨ªa o de guitarra para practicar encima de tu canci¨®n favorita¡±, comenta el investigador.

?C¨®mo escucha una m¨¢quina?

Durante a?os, el funcionamiento de sus orejas se fue derivando de los otros campos pioneros en el desarrollo de habilidades artificiales, como el de la visi¨®n y el procesamiento del lenguaje natural. ¡°La primera forma de tratar de desarrollar tecnolog¨ªas basadas en este concepto fue adaptarlas directamente. Tomamos la arquitectura de visi¨®n por computador y la aplicamos directamente al audio¡±, precisa Pons. No en vano, el c¨ªrculo virtuoso de investigaci¨®n y financiaci¨®n de los campos m¨¢s aventajados daba como resultado una mayor disponibilidad de desarrollos y tutoriales de sistemas de este tipo. ¡°Las comunidades de visi¨®n por computador y speech recognition han sido hist¨®ricamente muy grandes. Esto significa que las empresas normalmente est¨¢n interesadas en sus temas. En el caso de la m¨²sica, muchas veces se dice que al no haber tanta industria digital, la comunidad siempre ha sido m¨¢s peque?a. Como no hay dinero, no hay tantos investigadores que hagan esto¡±.

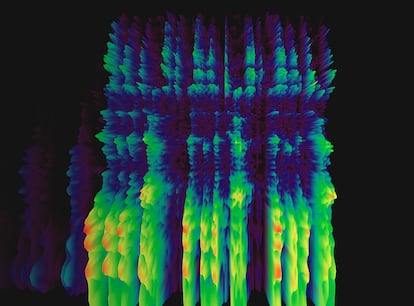

As¨ª, los abundantes algoritmos de visi¨®n artificial resultaron moderadamente efectivos a la hora de interpretar el sonido cuando este adoptaba un formato visual: el espectrograma. Pero lo hac¨ªan con las obvias limitaciones de usar una herramienta para un prop¨®sito distinto de aquel para el que fue creada. ¡°Estas representaciones tienen un significado distinto al de una imagen, que es espacio en s¨ª. En un espectrograma hay dos dimensiones, tiempo y frecuencia, que no tienen nada que ver con el espacio¡±, subraya el experto. Dise?ar las redes neuronales para interpretar toda esta informaci¨®n es lo que abre la puerta a nuevas perspectivas para el campo de la escucha artificial

?Qu¨¦ hace falta para que estas l¨ªneas de investigaci¨®n se pongan al nivel de sus predecesoras? Datos. En el caso de la visi¨®n artificial, ImageNet ha sido un recurso clave para los avances del campo. Esta base de datos, integrada por m¨¢s de 14 millones de im¨¢genes con sus correspondientes descripciones, ha estado a disposici¨®n de los investigadores desde 2009. ¡°En audio a¨²n no tenemos algo as¨ª¡±, sentencia Pons. Pero hay proyectos en marcha. ¡°Esto ha sido una parte importante de mi tesis, donde con mis compa?eros del Music Technology Group de la Universitat Pompeu Fabra hemos tratado de anotar un dataset -conjunto de datos- muy grande, y todo con licencias abiertas para que todo el mundo pueda entrenar sus modelos y ver si podr¨ªamos avanzar un poco el estado de la cuesti¨®n¡±, contin¨²a.

Los cimientos de este proyecto se pusieron en 2005, en la base de datos bautizada como FreeSound, que Pons describe como la web principal para compartir sonido online con licencias libres: ¡°Hay una comunidad muy grande, que pone al grupo en la posici¨®n de crear bases de datos abiertas, libres y para toda la comunidad cient¨ªfica¡±. Esto no es moco de pavo, en un ¨¢mbito donde las licencias son una barrera constante. ¡°Compartir sonidos, en general, es un poco complicado legalmente¡±, a?ade Pons. Y si hablamos de m¨²sica comercial, las posibilidades son a¨²n m¨¢s limitadas: ¡°No existen. Por eso, construir un dataset con licencias libres para el campo de audio y m¨²sica es fundamental¡±.

Puedes seguir a EL PA?S TECNOLOG?A RETINA en Facebook, Twitter, Instagram o suscribirte aqu¨ª a nuestra Newsletter.

Tu suscripci¨®n se est¨¢ usando en otro dispositivo

?Quieres a?adir otro usuario a tu suscripci¨®n?

Si contin¨²as leyendo en este dispositivo, no se podr¨¢ leer en el otro.

FlechaTu suscripci¨®n se est¨¢ usando en otro dispositivo y solo puedes acceder a EL PA?S desde un dispositivo a la vez.

Si quieres compartir tu cuenta, cambia tu suscripci¨®n a la modalidad Premium, as¨ª podr¨¢s a?adir otro usuario. Cada uno acceder¨¢ con su propia cuenta de email, lo que os permitir¨¢ personalizar vuestra experiencia en EL PA?S.

?Tienes una suscripci¨®n de empresa? Accede aqu¨ª para contratar m¨¢s cuentas.

En el caso de no saber qui¨¦n est¨¢ usando tu cuenta, te recomendamos cambiar tu contrase?a aqu¨ª.

Si decides continuar compartiendo tu cuenta, este mensaje se mostrar¨¢ en tu dispositivo y en el de la otra persona que est¨¢ usando tu cuenta de forma indefinida, afectando a tu experiencia de lectura. Puedes consultar aqu¨ª los t¨¦rminos y condiciones de la suscripci¨®n digital.