Sabotaje al ¡®machine learning¡¯: ?chihuahua o ¡®muffin¡¯?

Desorientar algoritmos est¨¢ de moda. Estas son las t¨¦cnicas que se est¨¢n empleando para obstaculizar los avances del aprendizaje autom¨¢tico

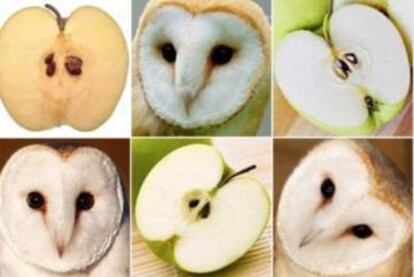

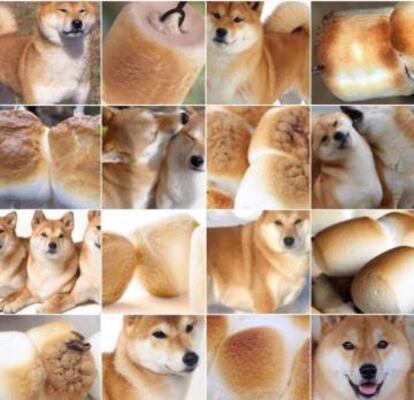

Culo o codo? Nos cuesta hasta a nosotros. Nadie condenar¨ªa a un algoritmo de machine learning por confundir lo uno con lo otro. Incluso podr¨ªamos perdonarle que tome a una lavadora por un altavoz. ?Qu¨¦ pasa cuando donde hay una tortuga de pl¨¢stico, nuestra m¨¢quina ve un rifle? El caso es real. Y el error no es casual. Los investigadores LabSix -un equipo formado por estudiantes del MIT- han explicado paso a paso c¨®mo consiguieron imprimir en 3D una tortuga de pl¨¢stico cuyos patrones de dise?o llevaban al algoritmo a ver un rifle.

El experimento, que tiene la particularidad de haberse hecho con un objeto en tres dimensiones y por tanto m¨¢s dif¨ªcil de falsear, funciona incluso mejor con im¨¢genes. Donde hab¨ªa un gato atigrado, la red neuronal encontr¨® guacamole. "Tambi¨¦n hicimos una pelota de b¨¦isbol que se clasifica como un expreso desde todos los ¨¢ngulos. Los ejemplos tambi¨¦n enga?aban a la red neuronal cuando los coloc¨¢bamos ante fondos sem¨¢nticamente relevantes. Por ejemplo, nunca ver¨¢s un rifle bajo el agua o un expreso en un guante de b¨¦isbol", explican.

Los algoritmos pueden sufrir alucinaciones. Y el problema engorda cuando sus espejismos no son fruto del azar sino que se han provocado con inputs modificados para forzar el error, como la tortuga-rifle o la pelota-expresso. Los peligros del adversarial machine learning -aprendizaje autom¨¢tico conflictivo o antag¨®nico- son algo m¨¢s que advertencias de los cenizos y agoreros de la era digital. Hasta Google est¨¢ midiendo las consecuencias que pueden tener estas tretas en una sociedad que se mueva al son del algoritmo.?"La mayor¨ªa de los clasificadores de machine learning existentes son altamente vulnerables a ejemplos conflictivos", se?alan.

Cajeros, coches aut¨®nomos y c¨¢maras de tr¨¢fico estar¨ªan a la merced de cambios imperceptibles para el ojo humano

"La gente no es muy consciente. Hay mucho hype alrededor de la inteligencia artificial y el machine learning, pero no nos damos cuenta de que ya hay ciberguerra por debajo", explica Alberto Robles, director general de Expert System en Espa?a. Sin salir del ordenador, una muestra conflictiva puede sortear los algoritmos de filtros de correo basura o detectores de malware. Un riesgo casi aceptable si se compara con lo que ocurre cuando los ataques llegan a sistemas que operan en el mundo f¨ªsico. Roman Trusov y Emil Mikhailov -de XIX AI- imaginaron en el blog de la aceleradora Y Combinator c¨®mo podr¨ªa ocurrir. Un cheque de 100 d¨®lares impreso con lo que al ojo humano le parecer¨ªa un poco de ruido podr¨ªa enga?ar a un cajero autom¨¢tico y canjearse por un mill¨®n. Peque?as modificaciones en una se?al podr¨ªan desorientar a los futuros coches aut¨®nomos: invalidar se?ales de Stop, aumentar l¨ªmites de velocidad... Y sin esperar a la conducci¨®n sin manos, un toque personal a la matr¨ªcula del veh¨ªculo podr¨ªa dejarla irreconocible para las c¨¢maras de tr¨¢fico.

"El impacto que esto puede tener a medio-largo plazo es muy grande", advierte Robles, cuya empresa presta sus servicios a aseguradoras que necesitan automatizar procesos de decisi¨®n complejos. "Algunas compa?¨ªas te piden una foto del coche cuando te das de alta, para ver que los cristales est¨¢n bien. Se ve que mucha gente aprovecha y se cambia para que le entre el arreglo. Esas fotos no las mira nadie, las mira un sistema. Y t¨² puedes meter ruido para que piense que est¨¢n bien", razona.

El truco es que nosotros tampoco ver¨ªamos nada amenazante en estos ejemplos. Como mucho, una imagen granulada o peque?os desperfectos en la pintura. Adem¨¢s, las alucinaciones de las m¨¢quinas tambi¨¦n pueden ser auditivas: seg¨²n demostraron en un estudio publicado hace pocas semanas dos investigadores de la Universidad de Berkeley, es posible construir ejemplos conflictivos de audio para sistemas de reconocimiento de voz. "A partir de cualquier onda de sonido predeterminada, podemos producir otra que es un 99,9% similar pero se transcribe como cualquier otra frase que elijamos, a un ratio de 50 caracteres por segundo", aseguraron Nicholas Carlini y David Wagner. Este sistema permitir¨ªa, por ejemplo, ocultar comandos de voz en una canci¨®n.

- Robin Hoods 4.0

Estos sabotajes tambi¨¦n se est¨¢n usando como arma para reconquistar nuestros datos y evitar que otros hagan su fortuna a trav¨¦s del expolio m¨¢s facil¨®n de la historia. Esta es la batalla que Dan Schultz, parte del equipo de Internet Archive, nos anima a librar metiendo ruido en la red. Con su propuesta no enga?amos al algoritmo, sino que le damos una manzana envenenada.

"Los publicistas no te dan lo que quieres, te manipulan para que quieras lo que tienen", denuncia Schultz. Con un solo clic en Internet Noise, nuestro explorador comenzar¨¢ a cargar sitios al azar en m¨²ltiples pesta?as. Si lo dejamos activo, llenar¨¢ sus bases de datos de basura sin significado: "pago vaqueros bien inflamaci¨®n", "entusiasmo aviso falsificaci¨®n bikini", "oro edificio timador", "dolor semilla", "literatura tigre gasto ingeniero". Internet Noise buscar¨¢ en Google t¨¦rminos aleatorios como estos, abrir¨¢ una web cualquiera y volver¨¢ a empezar.

- Guerra al circuito cerrado

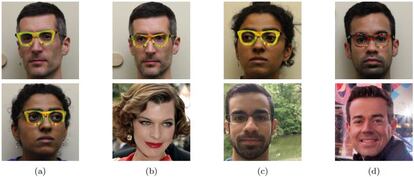

Otra cruzada cuya estrategia pasa por ofuscar algoritmos es la que reniega de las c¨¢maras de seguridad con tecnolog¨ªa de reconocimiento facial. La montura de las gafas que fabrica Reflectacles est¨¢ dise?ada para reflejar la luz que emiten las c¨¢maras de infrarrojos y convertir a quien las lleve en un destello sin rostro. Adem¨¢s, las Reflectacles producen el mismo efecto cuando las ilumina un coche, de modo que protegen a los peatones en condiciones de escasa visibilidad.

Pero los problemas de los sistemas de biometr¨ªa facial no terminan en las gafas reflectantes. De acuerdo con el estudio Accesorios para un crimen, publicado por la Asociaci¨®n de Maquinaria Inform¨¢tica (AMC), el simple patr¨®n de una montura no solo basta para provocar el error del algoritmo sino que puede llevarle a identificar a otra persona.

- Remedios defectuosos

"Si resolvemos esto, no lo har¨¢ un inform¨¢tico, sino un Nobel de Matem¨¢ticas", afirma Robles. Las aproximaciones actuales pasan por hacer remiendos al algoritmo. Son b¨¢sicamente que unas veces funcionan y otras no. Por ejemplo, en lo que se conoce como entrenamiento conflictivo se genera una masa de ejemplos de este tipo y se instruye al sistema para que los reconozca y no se deje enga?ar por ellos. Basta un ejemplo diferente para tumbar la barricada.

Ian Goodfellow y Nicholas Papernot, expertos en seguridad y privacidad en machine learning, todav¨ªa no ven la luz al final del t¨²nel. "Nadia ha dise?ado a¨²n un algoritmo de defensa verdaderamente poderoso que pueda resistir una amplia variedad de ataques conflictivos", escriben. La postura de Robles concuerda con esto: "Parte del problema es que la informaci¨®n de los buenos es casi p¨²blica. Nosotros mismos presentamos papers, hacemos workshops... Ellos pueden trabajar contra nuestra tecnolog¨ªa. Es como intentar hacer algoritmos de seguridad con el malo mir¨¢ndote por encima del hombro".

Tu suscripci¨®n se est¨¢ usando en otro dispositivo

?Quieres a?adir otro usuario a tu suscripci¨®n?

Si contin¨²as leyendo en este dispositivo, no se podr¨¢ leer en el otro.

FlechaTu suscripci¨®n se est¨¢ usando en otro dispositivo y solo puedes acceder a EL PA?S desde un dispositivo a la vez.

Si quieres compartir tu cuenta, cambia tu suscripci¨®n a la modalidad Premium, as¨ª podr¨¢s a?adir otro usuario. Cada uno acceder¨¢ con su propia cuenta de email, lo que os permitir¨¢ personalizar vuestra experiencia en EL PA?S.

?Tienes una suscripci¨®n de empresa? Accede aqu¨ª para contratar m¨¢s cuentas.

En el caso de no saber qui¨¦n est¨¢ usando tu cuenta, te recomendamos cambiar tu contrase?a aqu¨ª.

Si decides continuar compartiendo tu cuenta, este mensaje se mostrar¨¢ en tu dispositivo y en el de la otra persona que est¨¢ usando tu cuenta de forma indefinida, afectando a tu experiencia de lectura. Puedes consultar aqu¨ª los t¨¦rminos y condiciones de la suscripci¨®n digital.