M¨¢quinas que matan sin intervenci¨®n humana: la carrera para crearlas aventaja a los esfuerzos por regularlas

La ONU lleva m¨¢s de seis a?os intentando establecer un marco normativo para los llamados robots asesinos

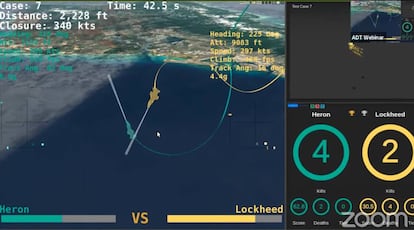

En 2024, el Pent¨¢gono espera enfrentar a pilotos humanos contra aviones controlados por inteligencia artificial en duelos reales. Lo anunci¨® el Secretario de Defensa de los Estados Unidos, Mark Esper, en una intervenci¨®n reciente. A mediados de agosto, los algoritmos desarrollados por Heron Systems ya hab¨ªan demostrado ser capaces de vencer a pilotos humanos en enfrentamientos simulados. Para Esper, la haza?a es una prueba del ¡°impacto tect¨®nico¡± que la inteligencia artificial y el machine learning van a tener en las guerras del futuro. Para quienes piden una regulaci¨®n que controle el desarrollo de armas capaces de matar sin intervenci¨®n humana, es un indicio m¨¢s de que la humanidad llega tarde.

¡°Incluso en estos tiempos de disrupci¨®n seguimos viendo m¨¢s y m¨¢s informes de nuevos tipos de armas que se est¨¢n estudiando, desarrollando y probando y que incorporan autonom¨ªa en sus funciones cr¨ªticas¡±. Estas fueron las palabras elegidas la semana pasada por Izumi Nakamitsu, secretaria general adjunta y alta representante para asuntos de desarme de la ONU, para inaugurar el encuentro del grupo de expertos gubernamentales sobre sistemas de armas letales aut¨®nomas (LAWS, por sus siglas en ingl¨¦s) en la Convenci¨®n sobre las Armas Convencionales de la misma entidad. Nakamitsu se?al¨® tambi¨¦n la urgencia de los avances del grupo, que lleva m¨¢s de seis a?os reuni¨¦ndose para buscar un marco que regule estas armas. Una vez m¨¢s y despu¨¦s de cinco d¨ªas de conversaciones, no hay resultados tangibles.

"Llevamos un a?o en una situaci¨®n de atasco. Hay una serie de potencias en la convenci¨®n que no tienen inter¨¦s en que surja una regulaci¨®n vinculante", se?ala Joaqu¨ªn Rodr¨ªguez, miembro de ICRAC y coordinador de la campa?a Stop Killer Robots en Espa?a. A este boicot suma la falta de decisi¨®n de otros pa¨ªses entre los que incluye a Espa?a. "La Uni¨®n Europea ha emitido diversas resoluciones pidiendo a los estados que se involucren en la negociaci¨®n. Luego todo acaba quedando relativamente en papel mojado", lamenta. Hasta el papa Francisco ha entrado en el debate. "Estamos presenciando una erosi¨®n del multilateralismo que es incluso m¨¢s seria a la vista del desarrollo de nuevas formas de tecnolog¨ªa militar, como los sistemas de armas letales aut¨®nomas, que irreversiblemente alteran la naturaleza de la guerra, desvincul¨¢ndola del control humano", advirti¨® el viernes en la 75 Asamblea General de la ONU.

Inevitablemente tarde

Las armas con diferentes grados de autonom¨ªa ya existen. "El avi¨®n no tripulado X-47B de la Marina de Estados Unidos, con un alcance de 3.800 km y una autonom¨ªa de seis horas de vuelo sin repostar, puede despegar de un portaaviones, volar al objetivo, ser reabastecido en vuelo, destruir el objetivo, regresar y aterrizar en el portaaviones", precisa Francisco Rubio Dami¨¢n, coronel de Infanter¨ªa de la Academia Militar de Zaragoza y director de la Ciudadela de Jaca. ¡°Es normal que las potencias militares desarrollen armas que les den una ventaja estrat¨¦gica decisiva sobre sus enemigos. Es inevitable y pensar lo contrario ser¨ªa solo un loable ejercicio de candidez¡±, razona Rubio, doctorado en Sociolog¨ªa y experto en Seguridad Global y Defensa.

En 2017, Estados Unidos, Rusia e Israel concentraban m¨¢s de la mitad de los proyectos mundiales de desarrollo de armas con alg¨²n tipo de autonom¨ªa en sus funciones, de acuerdo con los ¨²ltimos datos recopilados por el Instituto Internacional de Estudios para la Paz de Estocolmo (Sipri). Las categor¨ªas m¨¢s frecuentes eran entonces aeronaves y sistemas terrestres no tripulados, y sistemas de defensa antia¨¦rea. Para Rubio Dami¨¢n, la falta de avances en las negociaciones para que esa autonom¨ªa no se emplee de manera indiscriminada en funciones letales responde en parte al retraso en acometerlas. "Las reuniones se iniciaron cuando Estados Unidos, China y Rusia llevaban a?os en su particular carrera armament¨ªstica desarrollando robots militares".

En ausencia de una regulaci¨®n espec¨ªfica, el desarrollo de sistemas de armas letales aut¨®nomas se rige por lo que establece el derecho internacional humanitario (DIH). En este contexto, cualquier uso de fuerza debe cumplir los principios de proporcionalidad (los da?os a civiles no deben ser excesivos en relaci¨®n con la ventaja militar anticipada con la acci¨®n), distinci¨®n (debe hacerse todo lo posible por identificar inequ¨ªvocamente a civiles y combatientes) y necesidad (el objetivo debe justificarse como esencial para el avance del conflicto). ¡°El DIH pone los umbrales m¨ªnimos que deben satisfacer estas armas, al crear un marco que aplica a cualquier arma aut¨®noma. Sin embargo, las leyes actuales fracasan a la hora de establecer un rendimiento de cuentas por los cr¨ªmenes que se cometan con sistemas automatizados¡±, explica Bryan McMahon, investigador en pol¨ªticas de inteligencia artificial.

Imprevisibilidad y cajas negras

?Por qu¨¦ importa esto? Por que estas armas pueden cometer errores en el campo de batalla. Igual que ocurre en las carreteras, los juicios, la identificaci¨®n de individuos y la vida real en general, el uso de estos sistemas puede derivar en resultados imprevisibles o imposibles de explicar. Arthur Holland, investigador asociado de inteligencia artificial y autonom¨ªa del Instituto para la investigaci¨®n del desarme de las Naciones Unidas (UNIDIR), compara los riesgos de la autonom¨ªa en un arma con los que entra?ar¨ªa una tostadora. ¡°Pongamos que tienes una tostadora dise?ada para funcionar en una cocina con la temperatura controlada, y la utilizas a temperaturas bajo cero. Seguramente no funcionar¨¢ igual¡±, explic¨® la semana pasada en el coloquio organizado por UNIDIR en paralelo al encuentro del grupo de expertos. Su interlocutora, Pascale Fung, es directora del Centro para la Investigaci¨®n en Inteligencia Artificial en Hong Kong y atribuye este fallo al entorno: cuando un sistema no est¨¢ entrenado para determinados escenarios puede no ser capaz de gestionarlos.

"Adem¨¢s, a veces el problema no es el entorno sino el input. Si tu tostadora estaba entrenada para tostar pan de centeno y en las pruebas de campo introduces un bagel, el resultado puede ser cualquier otro", explic¨® Fung. El problema es que en este caso no est¨¢n en juego el desayuno y las paredes de la cocina, sino las vidas de quienes se ven envueltos por un conflicto b¨¦lico: una m¨¢quina entrenada en zonas boscosas puede fallar en el desierto y otra entrenada para detectar objetivos con im¨¢genes de personas cauc¨¢sicas puede funcionar de manera distinta ante individuos de otras razas.

?Llegar¨¢n a la guerra?

No est¨¢ pr¨®ximo el momento en que veamos Terminators en el campo de batalla. Un sistema as¨ª implicar¨ªa un nivel de sofisticaci¨®n que no se ha alcanzado. Adem¨¢s, las gu¨ªas elaboradas por el grupo de expertos en su reuni¨®n de 2019 recomiendan evitar el desarrollo de armas aut¨®nomas con forma humana. "Los expertos afirman que antropomorfizar los robots podr¨ªa llevarnos a expectativas poco realistas de la capacidad de razonamiento y juicio moral de las m¨¢quinas", explica McMahon.

Sin embargo, el experto est¨¢ convencido de que veremos otros conceptos armas capaces de matar sin intervenci¨®n humana antes de lo que pensamos: "Aunque la tecnolog¨ªa no est¨¢ madura todav¨ªa, la creciente presi¨®n geopol¨ªtica empuja las LAWS cada vez m¨¢s cerca del campo de batalla". Rubio, por su parte, admite que la tecnolog¨ªa existe, pero cree que es "poco probable" que la veamos en acci¨®n. "Las potencias militares har¨¢n todo lo que sea necesario para no estigmatizar esta tecnolog¨ªa y evitar¨¢n por todos los medios que se produzca un error fatal que pueda ser achacado al empleo de robots militares".

A la imprevisibilidad se suman las dificultades para seguir y comprender el razonamiento del algoritmo. Un sistema puede aparentar absoluta precisi¨®n en el reconocimiento de combatientes y estar basando su identificaci¨®n no en las personas, sino en el paisaje de fondo. Si no se abre la caja negra y se desentra?a la l¨®gica fallida de estas decisiones, no es posible corregir el error. "La tecnolog¨ªa creada para hacer m¨¢s humana la guerra puede convertirse en las armas m¨¢s brutales del campo de batalla", advierte McMahon.

"Uno de los principales problemas a los que nos enfrentamos es que hay Estados que repiten como un mantra afirmaciones que son mentira", comienza Rodr¨ªguez. El portavoz de ICRAC se refiere a quienes aseguran que es posible crear LAWS a prueba de errores. "Siempre hay m¨¢rgenes de error", insiste. En este contexto, la exigencia contra la que reman las grandes potencias b¨¦licas es que siempre haya una persona al volante en el momento en que la m¨¢quina plantea una acci¨®n letal. ?Es suficiente? Al menos entra dentro de lo humanamente controlable, se?ala Rubio. "Deber¨ªa ser garant¨ªa suficiente de que el robot militar no provocar¨¢ da?os superfluos o sufrimientos innecesarios. Si otorgamos esa confianza en el soldado-combatiente, aunque no siempre cumpla, no hay motivos para no otorgar la misma confianza al soldado-operador del sistema aut¨®nomo".

En noviembre, el grupo de expertos volver¨¢ a reunirse, pero Rodr¨ªguez se muestra esc¨¦ptico, dada la complejidad de la situaci¨®n. "Los recursos que se est¨¢n manejando son alt¨ªsimos. Pensar que todos esos pa¨ªses est¨¢n dispuestos a congelar los activos que han puesto en investigaci¨®n armament¨ªstica es poco realista", argumenta. El experto no descarta que estas negociaciones puedan avanzar fuera del marco de la ONU, pero insiste en que la instituci¨®n ser¨ªa el marco ideal. "Los pa¨ªses que est¨¢n realizando un boicot no solo est¨¢n dificultando este tratado sino la resoluci¨®n de controversias a escala internacional de una manera dialogada".

Puedes seguir a EL PA?S TECNOLOG?A RETINA en Facebook, Twitter, Instagram o suscribirte aqu¨ª a nuestra Newsletter.

Tu suscripci¨®n se est¨¢ usando en otro dispositivo

?Quieres a?adir otro usuario a tu suscripci¨®n?

Si contin¨²as leyendo en este dispositivo, no se podr¨¢ leer en el otro.

FlechaTu suscripci¨®n se est¨¢ usando en otro dispositivo y solo puedes acceder a EL PA?S desde un dispositivo a la vez.

Si quieres compartir tu cuenta, cambia tu suscripci¨®n a la modalidad Premium, as¨ª podr¨¢s a?adir otro usuario. Cada uno acceder¨¢ con su propia cuenta de email, lo que os permitir¨¢ personalizar vuestra experiencia en EL PA?S.

?Tienes una suscripci¨®n de empresa? Accede aqu¨ª para contratar m¨¢s cuentas.

En el caso de no saber qui¨¦n est¨¢ usando tu cuenta, te recomendamos cambiar tu contrase?a aqu¨ª.

Si decides continuar compartiendo tu cuenta, este mensaje se mostrar¨¢ en tu dispositivo y en el de la otra persona que est¨¢ usando tu cuenta de forma indefinida, afectando a tu experiencia de lectura. Puedes consultar aqu¨ª los t¨¦rminos y condiciones de la suscripci¨®n digital.