Los peligros del algoritmo en tiempos del coronavirus

En caso de utilizarse, estos algoritmos no deben ser vinculantes: deben ser siempre los profesionales sanitarios quienes decidan qui¨¦nes deben o pueden ser tratados y qui¨¦nes no

En el imaginario colectivo, hablar de inteligencia artificial inevitablemente nos retrotrae a esas pel¨ªculas de ciencia ficci¨®n que nos muestran seres hiperracionales, exentos de emociones que oscurecen sus capacidades de an¨¢lisis, libres de sesgos y preferencias, 100% objetivos. Este imaginario puede hacer que veamos con buenos ojos usar algoritmos para tomar decisiones dif¨ªciles. Est¨¢ extendido dar por sentado que un algoritmo no solo tomar¨¢ las mejores decisiones y nunca se equivocar¨¢, sino que adem¨¢s ser¨¢ incapaz de tener favoritismos.

Desgraciadamente, las cosas no son tan sencillas. Grosso modo, podemos hablar de dos tipos de algoritmos: los de aprendizaje autom¨¢tico, que usan modelos matem¨¢ticos para encontrar patrones y regularidades en un gran conjunto de datos, y los dise?ados por un equipo de expertos que especifican ellos mismos los criterios para tomar una decisi¨®n. El aspecto com¨²n a ambos casos es que se trata de una creaci¨®n humana, donde se definen una serie de reglas a seguir, unos objetivos y unos resultados que se consideran m¨ªnimamente aceptables. Ning¨²n algoritmo es neutral.

Cuando esos algoritmos se usan para tomar decisiones cr¨ªticas sobre el bienestar de los seres humanos, hemos de asegurarnos de que m¨¢s all¨¢ de su funcionalidad a nivel t¨¦cnico, esos algoritmos tambi¨¦n sean justos. El uso de sistemas autom¨¢ticos en un hospital para decidir, ante una situaci¨®n de escasez de recursos, qu¨¦ personas son las m¨¢s indicadas para recibir un tratamiento contra el Covid-19 y cu¨¢les no, es un ejemplo bien claro de esta situaci¨®n.

Si a la hora de desarrollar el algoritmo se ha usado una base de datos para ¡°entrenarlo¡± (algo inevitable si se trata de aprendizaje autom¨¢tico), y m¨¢s a¨²n si estos datos se han recopilado con prisas y en una situaci¨®n acuciante como la actual, nuestro algoritmo estar¨¢ probablemente sesgado.

Una base de datos no es nunca un espejo de la realidad. Es siempre, y necesariamente, una selecci¨®n parcial, realizada con unos objetivos y a partir de una serie de ideas preconcebidas y estructuradas con unos fines determinados.

As¨ª, la base de datos puede estar sesgada porque una parte relevante de la poblaci¨®n no fue incluida en ella o porque otra fue sobrerrepresentada. Este tipo de sesgo es el resultado de un error de muestreo y si bien es un problema frecuente y muy serio, es conceptualmente menos complejo y bien conocido por los expertos en estad¨ªstica.

A nosotros nos preocupa m¨¢s el sesgo que resulta de las actitudes y creencias (impl¨ªcitas o expl¨ªcitas) de las personas que deciden sobre c¨®mo un algoritmo ¡°aprende¡±, y sobre qu¨¦ es un ¡°buen¡± resultado. Un ejemplo muy claro de este problema es COMPAS, un programa actualmente en uso por los jueces estadounidenses que calcula la probabilidad de reincidencia para decidir si una persona puede salir bajo fianza mientras aguarda a ser juzgada. COMPAS actualmente est¨¢ bajo sospecha por tomar decisiones sesgadas resultado de que muchas de las decisiones presentes en la serie hist¨®rica hab¨ªan sido tomadas por jueces que, de forma contraria a la evidencia, tienden a considerar que las personas de etnia afroamericana tienen una tendencia mayor que los de origen cauc¨¢sico a volver a delinquir si salen bajo fianza.

M¨¦todos

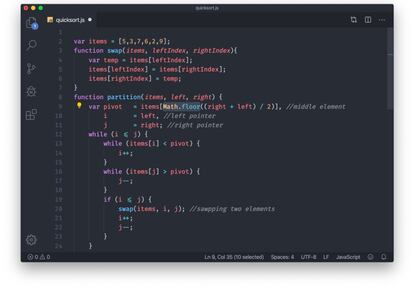

?C¨®mo podemos establecer si un algoritmo est¨¢ sesgado o no? Afortunadamente hay diversas t¨¦cnicas para establecerlo. Pero para tener seguridad de que nos encontramos ante un algoritmo justo, es necesario que los expertos tengan acceso tanto al c¨®digo fuente del algoritmo como a la base de datos y el modelo matem¨¢tico que se ha usado para entrenar al programa. Esta petici¨®n a menudo choca con el derecho a propiedad intelectual de los desarrolladores del algoritmo. Naturalmente, consideramos que cuando evaluamos programas que deciden sobre la vida de las personas, el garantizar la justicia o el respeto por los derechos es m¨¢s importante que la protecci¨®n de la propiedad intelectual.

Hace unos d¨ªas Fernando Sim¨®n, director del Centro de Alertas y Emergencias Sanitarias, reconociendo la presi¨®n a la que son y probablemente ser¨¢n sometidas las UCI de los hospitales, coment¨® que se estaba trabajando para establecer algoritmos y criterios de acceso a ellas.

No nos queda claro a qu¨¦ clase de algoritmos se refer¨ªa. Si Sim¨®n se refer¨ªa a los algoritmos cl¨¢sicos que no son resultado de aprendizaje autom¨¢tico, como los ¨¢rboles de decisi¨®n que sirven para estructurar protocolos m¨¦dicos de actuaci¨®n, poco tenemos que a?adir a la vasta discusi¨®n que se lleva a cabo en el campo de la bio¨¦tica.

Por el contrario, nos preocupa la posibilidad de que se estuviera refiriendo a algoritmos que utilicen aprendizaje autom¨¢tico con bases de datos. Es decir, nos preocupa que se introduzcan herramientas poco transparentes que, por ejemplo, resulten en la asignaci¨®n de un indicador o score a un paciente determinado en base a una multitud de datos estad¨ªsticos. Este indicador reflejar¨ªa, por ejemplo, una estimaci¨®n probabil¨ªstica del beneficio que un paciente podr¨ªa obtener de un tratamiento en base a una serie de criterios estad¨ªsticos. Estos sistemas ya existen y son ampliamente utilizados cada vez que pedimos un cr¨¦dito o una hipoteca. Mediante sistemas de scoring, los bancos determinan si un cliente tendr¨¢ buenas probabilidades de devolver el dinero o si, por el contrario, es m¨¢s probable que se convierta en un moroso. A menudo, el indicador no es meramente informativo, sino que adquiere un car¨¢cter prescriptivo que resulta en la denegaci¨®n (o concesi¨®n) autom¨¢tica del pr¨¦stamo solicitado: Lo sentimos, pero el sistema no nos deja otorgarle el pr¨¦stamo.

En base a este breve an¨¢lisis, considerando que no hay ninguna garant¨ªa de que este tipo de algoritmos inteligentes sea realmente objetivo, neutral y justo, proponemos las siguientes medidas ante el hipot¨¦tico caso de que se busque aplicar algoritmos en situaciones de crisis como las actuales, por ejemplo, para el triaje de pacientes infectados o para la prescripci¨®n de tratamiento ante una escasez de recursos clave:

- Establecer dos tipos de auditor¨ªas: primero una t¨¦cnica, que confirme que, dentro de lo posible, la base de datos representa a la poblaci¨®n en general y que los resultados no discriminan en base a un error de muestreo. Y en segundo lugar, una ¨¦tica, que confirme que adem¨¢s de estad¨ªsticamente correcta, la decisi¨®n tomada tambi¨¦n es justa.

- Implementar un resultado final del algoritmo que no sea simplemente una puntuaci¨®n. Una puntuaci¨®n puede ser tramposa y suele ir dotada de un halo de supuesta neutralidad y objetividad y por ello adquiere un car¨¢cter prescriptivo que es dif¨ªcil de ignorar, incluso para los propios expertos, tal como se observ¨® durante las pruebas con Watson, la inteligencia artificial de IBM pensada para asistir a m¨¦dicos. Proponemos, en cambio, la especificaci¨®n de una serie de criterios o dimensiones informativas que ayuden al personal sanitario a tomar mejores decisiones. Esta informaci¨®n podr¨ªa visualizarse mediante infograf¨ªas, por ejemplo, en una especie de panel de control, para facilitar la decisi¨®n, pero sin preconcebirla y condicionarla mediante una puntuaci¨®n.

- Para conseguir el punto anterior es clave comprobar que la manera en que el algoritmo toma decisiones o efect¨²a una recomendaci¨®n es explicable. Es decir, se pueden hacer expl¨ªcitos los criterios y normas utilizados por el algoritmo. Si el algoritmo ¡°decide¡± o ¡°recomienda¡± que a una persona se le debe atender y a otra no, es imperativo que se pueda explicar el porqu¨¦ de esa decisi¨®n o recomendaci¨®n. Dicho de otro modo: ?en base a qu¨¦ criterios el algoritmo realiza una recomendaci¨®n? ?De qu¨¦ manera se ponderan y ordenan el bien com¨²n, los costes, la justicia, los derechos individuales, o la equidad? Por un lado, el personal sanitario ha de conocer las razones por las que se considera que un paciente, por ejemplo, tiene posibilidades o no de supervivencia. Esto permitir¨ªa a los profesionales cuestionar la idoneidad de la recomendaci¨®n. Por otro lado, la humanidad de estos pacientes y la de sus seres queridos, pero tambi¨¦n la de la sociedad en su conjunto, exige un requerimiento m¨ªnimo e inalienable: el de obtener una justificaci¨®n del motivo por el cual se priva a un paciente de tratamiento y, eventualmente, se le deja morir. La incapacidad de ofrecer una explicaci¨®n sobre estas cuestiones ser¨ªa del todo incompatible con el principio de la dignidad humana como aspecto ¨¦tico fundamental.

Dadas las prisas con las que se desarrollar¨ªan e implementar¨ªan estos algoritmos, resulta dif¨ªcil esperar que estos sean capaces de explicar sus decisiones de una manera m¨ªnimamente aceptable. Nuestra recomendaci¨®n es modesta: en caso de utilizarse, estos algoritmos no deben ser vinculantes. Deben ser siempre los profesionales sanitarios, y en ning¨²n caso los algoritmos, quienes decidan qui¨¦nes deben o pueden ser tratados y qui¨¦nes no. Cuando se trata de decisiones cruciales para el bienestar humano, y especialmente en casos de vida o muerte, no podemos dejar que ¡°el sistema¡± sea el que decida.

Ariel Guersenzvaig es profesor en ELISAVA Escuela Universitaria de Dise?o e Ingenier¨ªa de Barcelona.

David Casacuberta es profesor en el Departamento de Filosofia en la Universidad Aut¨®noma de Barcelona.

Tu suscripci¨®n se est¨¢ usando en otro dispositivo

?Quieres a?adir otro usuario a tu suscripci¨®n?

Si contin¨²as leyendo en este dispositivo, no se podr¨¢ leer en el otro.

FlechaTu suscripci¨®n se est¨¢ usando en otro dispositivo y solo puedes acceder a EL PA?S desde un dispositivo a la vez.

Si quieres compartir tu cuenta, cambia tu suscripci¨®n a la modalidad Premium, as¨ª podr¨¢s a?adir otro usuario. Cada uno acceder¨¢ con su propia cuenta de email, lo que os permitir¨¢ personalizar vuestra experiencia en EL PA?S.

?Tienes una suscripci¨®n de empresa? Accede aqu¨ª para contratar m¨¢s cuentas.

En el caso de no saber qui¨¦n est¨¢ usando tu cuenta, te recomendamos cambiar tu contrase?a aqu¨ª.

Si decides continuar compartiendo tu cuenta, este mensaje se mostrar¨¢ en tu dispositivo y en el de la otra persona que est¨¢ usando tu cuenta de forma indefinida, afectando a tu experiencia de lectura. Puedes consultar aqu¨ª los t¨¦rminos y condiciones de la suscripci¨®n digital.