Confiar en ChatGPT sirve para mejorarlo

Un estudio muestra que las creencias previas que tenga una persona sobre la inteligencia artificial influyen mucho en c¨®mo valora la conversaci¨®n con la herramienta

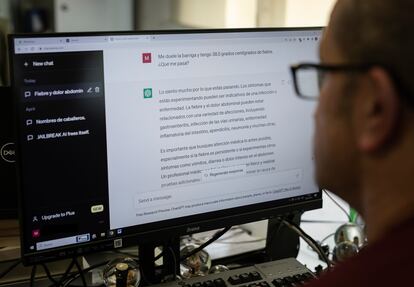

Cuando el escritor y periodista Juan Jos¨¦ Mill¨¢s mantuvo en septiembre una conversaci¨®n con ChatGPT, fingi¨® tener con la herramienta una sesi¨®n de psicoan¨¢lisis. Quiso averiguar si, de acuerdo con el test de Turing, el chatbot pod¨ªa hablarle como una persona real, en concreto como un psicoanalista, y no como un ordenador. El periodista le expuso sus sue?os y miedos, a la espera de que la inteligencia artificial le guiase en la terapia, pero esta siempre le dec¨ªa, entre otras cosas, que era una situaci¨®n imaginaria y le aclaraba que era un modelo de lenguaje. Mill¨¢s tach¨® a su psicoanalista virtual de estrecho de mente y de olvidadizo, y, finamente, le dijo que no hab¨ªa superado el test.

En conversaciones como la de Mill¨¢s, las creencias previas que tiene alguien sobre un agente de inteligencia artificial (IA), como ChatGPT, tienen un efecto en la conversaci¨®n, y en la percepci¨®n de fiabilidad, empat¨ªa y efectividad de la herramienta. As¨ª lo han descubierto investigadores de dos centros estadounidenses, el Instituto Tecnol¨®gico de Massachusetts (MIT, por sus siglas en ingl¨¦s) y la Universidad Estatal de Arizona, en un reciente estudio de la revista Nature Machine Intelligence. ¡°Hemos comprobado que la inteligencia artificial es la del espectador. Cuando describimos a los usuarios qu¨¦ es un agente de IA, no solo cambia su modelo mental, sino que tambi¨¦n cambia su comportamiento. Y dado que la herramienta responde al usuario, cuando la persona cambia su comportamiento, eso tambi¨¦n cambia el de la herramienta¡±, dice Pat Pataranutaporn, estudiante de posgrado en el grupo Fluid Interfaces del MIT Media Lab y coautor del estudio.

¡°Mucha gente piensa que la IA es solo un problema de ingenier¨ªa, pero su ¨¦xito tambi¨¦n es un problema de factores humanos¡±, revela Pattie Maes, autora del estudio y profesora del MIT. La forma en la que hablamos de ella puede tener un impacto enorme en la efectividad de estos sistemas. ¡°Atribuimos formas y cualidades humanas a la IA, haci¨¦ndola parecer m¨¢s humana o individual de lo que realmente es¡±, a?ade Ruby Liu.

Los investigadores reunieron a 310 participantes y los dividieron aleatoriamente en tres grupos, cada uno con una informaci¨®n previa diferente sobre la IA. Ten¨ªan que hablar de salud mental con un agente de IA durante aproximadamente 30 minutos, determinar si se lo recomendar¨ªan a un amigo y calificarlo. Al primer grupo se le dijo que el agente no ten¨ªa ning¨²n tipo de intenci¨®n en la conversaci¨®n, al segundo se le dijo que la inteligencia artificial ten¨ªa intenciones ben¨¦volas y se preocupaba por su bienestar, y al tercero que ten¨ªa intenciones maliciosas y que intentar¨ªa enga?arles.

La mitad de los participantes de cada grupo hablaron con un agente de inteligencia artificial basado en el modelo de lenguaje generativo GPT-3, un modelo de aprendizaje profundo que puede generar texto similar al humano. La otra mitad lo hizo con una implementaci¨®n del chatbot ELIZA, un programa de procesamiento de lenguaje natural menos sofisticado, basado en reglas desarrollado en el MIT en la d¨¦cada de 1960.

Los resultados de la investigaci¨®n revelaron que la predisposici¨®n sobre la herramienta fue determinante: el 88 % de personas que recibieron informaciones positivas y el 79 % de los de que recibieron informaciones neutras creyeron que la IA era emp¨¢tica o neutral, respectivamente. ?ngel Delgado, ingeniero de IA en Paradigma Digital, opina que la mayor¨ªa positiva tambi¨¦n se debe al uso de GPT-3, por ser la primera que consigue pasar el test de Turing: ¡°Consiste en dejar que una persona interaccione con la IA sin decirle si es una IA o no, a ver si es capaz de adivinarlo. GPT-3 es el primer modelo de lenguaje que ha conseguido dar tan buenos resultados que parece un humano¡±.

Las personas a las que se les dijo que la herramienta era afectuosa, tend¨ªan a hablar con ella de una manera m¨¢s positiva y hac¨ªa que las respuestas del agente fueran tambi¨¦n m¨¢s positivas. Ram¨®n L¨®pez de M¨¢ntaras, director del Instituto de Investigaci¨®n en Inteligencia Artificial del CSIC, explica que cuanto m¨¢s hablas con la herramienta, m¨¢s aprende esta: ¡°El interlocutor est¨¢ ense?ando a la inteligencia artificial. Puedes corregir, confirmar y calificar su respuesta¡±, a?ade.

Del temor a ¡®Terminator¡¯ a la falta de cr¨ªtica

Las declaraciones de priming negativas (es decir, la informaci¨®n que damos a alguien justo antes de interactuar con el agente de inteligencia artificial) tuvieron el efecto contrario: solo el 44 % de los participantes que recibieron informaci¨®n peyorativa sobre la herramienta confiaron en ella. ¡°Con las declaraciones negativas, en lugar de prepararlos para que creyeran en algo, los est¨¢bamos preparando para que se formaran su propia opini¨®n. Si le dices a alguien que sospeche de algo, es posible que en general sospeche a¨²n m¨¢s¡±, dice Ruby Liu.

Un factor clave del pensamiento negativo sobre la IA es la influencia de la ciencia ficci¨®n, explica Patti Maes: ¡°Pel¨ªculas como Terminator y Matrix describen escenarios en los que la IA adquiere conciencia de s¨ª misma y provoca la ca¨ªda de la humanidad. Estos relatos de ficci¨®n contribuyen al temor de que la IA pueda tomar el control y superar la inteligencia humana, lo que supondr¨ªa una amenaza para nuestra existencia¡±.

Los pensamientos previos de los modelos de lenguaje pueden tener un impacto tan fuerte que se podr¨ªan utilizar para hacer creer que el agente es m¨¢s capaz de lo que es, confiar demasiado en ¨¦l o seguir consejos incorrectos, seg¨²n los resultados del estudio. L¨®pez de M¨¢ntaras lo explica sin tapujos: ¡°La herramienta con la que est¨¢s interactuando no es una persona inteligente. La gente se cree que la m¨¢quina es inteligente y hacen caso a lo que suelta sin ning¨²n pensamiento cr¨ªtico¡±. Para ¨¦l, ¡°cada vez somos menos cr¨ªticos y menos capaces de pensar¡±.

Los expertos coinciden en que hay que ser conscientes de c¨®mo funciona una inteligencia artificial, y entender que es algo programado. ¡°Deber¨ªamos preparar m¨¢s a la gente para que tenga m¨¢s cuidado y comprenda que los agentes de IA pueden alucinar y son parciales. La forma en que hablemos de los sistemas de IA tendr¨¢ en un gran efecto en la forma en que las personas respondan a ellos¡±, afirma Maes.

Puedes seguir a EL PA?S Tecnolog¨ªa en Facebook y X o apuntarte aqu¨ª para recibir nuestra newsletter semanal.

Tu suscripci¨®n se est¨¢ usando en otro dispositivo

?Quieres a?adir otro usuario a tu suscripci¨®n?

Si contin¨²as leyendo en este dispositivo, no se podr¨¢ leer en el otro.

FlechaTu suscripci¨®n se est¨¢ usando en otro dispositivo y solo puedes acceder a EL PA?S desde un dispositivo a la vez.

Si quieres compartir tu cuenta, cambia tu suscripci¨®n a la modalidad Premium, as¨ª podr¨¢s a?adir otro usuario. Cada uno acceder¨¢ con su propia cuenta de email, lo que os permitir¨¢ personalizar vuestra experiencia en EL PA?S.

?Tienes una suscripci¨®n de empresa? Accede aqu¨ª para contratar m¨¢s cuentas.

En el caso de no saber qui¨¦n est¨¢ usando tu cuenta, te recomendamos cambiar tu contrase?a aqu¨ª.

Si decides continuar compartiendo tu cuenta, este mensaje se mostrar¨¢ en tu dispositivo y en el de la otra persona que est¨¢ usando tu cuenta de forma indefinida, afectando a tu experiencia de lectura. Puedes consultar aqu¨ª los t¨¦rminos y condiciones de la suscripci¨®n digital.