John Etchemendy: ¡°La tecnolog¨ªa tiene un enorme potencial para hacer da?o¡±

Nieto de un pastor navarro emigrado a Nevada el siglo pasado, el fil¨®sofo John Etchemendy fue hasta 2017 el rector de la Universidad de Stanford. Ahora esa instituci¨®n le ha encargado un reto apasionante: evitar que los seres humanos desarrollemos la inteligencia artificial de forma tan negligente que un d¨ªa los robots puedan convertirse en nuestros peores enemigos. Esa posibilidad ya tiene hoy algunos ejemplos.

JOHN ETCHEMENDY no es el tipo de personaje que uno espera encontrarse en Silicon Valley. Se trata de un veterano de la labor acad¨¦mica, que ha dedicado toda su vida a la reflexi¨®n y el an¨¢lisis. Es un humanista m¨¢s interesado en el pensamiento que en la acci¨®n. Su especialidad es el lenguaje, sus or¨ªgenes y sus complicados laberintos para la expresi¨®n de ideas. Su v¨ªnculo con la Universidad de Stanford se remonta a 1982, cuando obtuvo all¨ª su graduaci¨®n como fil¨®sofo, y culmin¨® en el a?o 2000 con su nombramiento como rector, cargo que ocup¨® hasta 2017.

Su actividad en Stanford, el centro que act¨²a como sost¨¦n intelectual de toda la revoluci¨®n tecnol¨®gica que se ha producido en las ¨²ltimas d¨¦cadas en la zona, le permiti¨® familiarizarse con las figuras y las innovaciones que continuamente surg¨ªan a su alrededor. Pero nunca perdi¨® la referencia de sus aut¨¦nticas pasiones acad¨¦micas ni disminuy¨® su inclinaci¨®n por cuestionar cualquier ortodoxia imperante. Su libro m¨¢s famoso, The Concept of Logical Consequence (El concepto de la consecuencia l¨®gica), est¨¢ considerado por los expertos como una obra maestra que desaf¨ªa la l¨®gica impuesta durante siglos sobre la construcci¨®n del lenguaje y la ordenaci¨®n del pensamiento.

Antes de abandonar su funci¨®n como rector decidi¨®, tambi¨¦n a contracorriente, responder a lo que considera una ola de intolerancia cultural que est¨¢ actualmente amenazando la libertad y la creaci¨®n en las universidades de Estados Unidos y quiz¨¢ de todo el mundo. ¡°He visto un crecimiento de la intolerancia en las universidades de este pa¨ªs. No hablo de intolerancia por razones de raza, de etnia o de sexo ¡ªen esos apartados, precisamente, se ha hecho un progreso muy loable¡ª. Me refiero a una intolerancia intelectual, a una imposici¨®n pol¨ªtica de un solo lado, que es la ant¨ªtesis de lo que una universidad debe hacer¡±, advert¨ªa Etchemendy a los miembros del Patronato de Stanford.

En su discurso de despedida record¨®: ¡°Como instituci¨®n, somos continuamente presionados por las Facultades y por los estudiantes para tomar posiciones pol¨ªticas, y cada vez que nos negamos a hacerlo se nos acusa de falta de coraje. En las universidades, hoy, lo m¨¢s f¨¢cil es sucumbir a esa presi¨®n. Lo que realmente requiere coraje es resistirla¡±. Pidi¨® a su universidad ¡°no descartar los puntos de vista distintos como si fueran malvados, ignorantes o est¨²pidos¡±, sino, al contrario, convertirlos en ¡°interlocutores valiosos¡±. ¡°Sucumbimos al pensamiento ¨²nico porque es m¨¢s f¨¢cil y m¨¢s c¨®modo que el pensamiento racional, pero cuando lo hacemos estamos abandonando la misi¨®n a la que una instituci¨®n como esta debe servir¡±.

Su historia personal tampoco es muy com¨²n. Etchemendy, como su nombre revela, tiene ra¨ªces vascas. Es el nieto de un pastor emigrado desde el norte de Navarra a Nevada a principios del siglo pasado. Nevada, junto a Idaho, es el Estado que re¨²ne la mayor concentraci¨®n de norteamericanos de ese origen. ?l habla con orgullo de sus antepasados e incluso puso en marcha durante algunos a?os un centro de estudios vascos en Stanford, del que se sirvi¨® en su d¨ªa el lendakari Iba?rretxe para contar su proyecto independentista en Estados Unidos. Etchemendy no parece ahora muy interesado en los asuntos espa?oles; ni siquiera se atreve a usar en p¨²blico el espa?ol que aprendi¨® durante unos a?os de juventud en Puerto Rico.

Su preocupaci¨®n ahora, a los 67 a?os, est¨¢ muy lejos de todo eso, muy lejos incluso de sus recientes obligaciones universitarias y pasiones intelectuales. Su ocupaci¨®n hoy, dicho en t¨¦rminos elementales pero que Etchemendy acepta y comparte, es evitar que desarrollemos la inteligencia artificial de forma tan negligente que un d¨ªa los robots puedan convertirse en nuestros peores enemigos.

S¨ª, suena improbable, y lo es, por el momento. Pero la Universidad de Stanford y parte de la industria perciben ya riesgos suficientes como para reunir a un grupo de expertos que velar¨¢n por el buen uso de la inteligencia artificial y tratar¨¢n de definir las reglas adecuadas.

La inteligencia artificial es desde hace tiempo el gran asunto en Silicon Valley. Tambi¨¦n es la gran apuesta y la gran inversi¨®n. No hay empresa relevante en el entorno que no est¨¦ implicada en alg¨²n proyecto que tenga que ver con esa materia. Todo el mundo est¨¢ convencido de que la inteligencia artificial, que ya es una parte importante de nuestra vida, intervendr¨¢ en pr¨¢cticamente todas las actividades humanas en poco tiempo y suplantar¨¢ muchas de ellas antes de lo que creemos.

Ante esa convicci¨®n, unida a la preocupaci¨®n sobre los efectos que esa revoluci¨®n est¨¢ teniendo y tendr¨¢ para la humanidad, para el mundo que hemos conocido y conocemos, Stanford encarg¨® en marzo a Etchemendy y a una reconocida pionera tecnol¨®gica, Fei-Fei Li, antigua vicepresidenta de Google, dirigir un grupo de trabajo que debe iluminarnos a todos sobre las virtudes y amenazas de la inteligencia artificial.

El centro creado tiene un nombre largo que explica muy bien su misi¨®n: Instituto para la Inteligencia Artificial Centrada en los Humanos. Se le conoce como HAI, por la abreviaci¨®n de sus siglas en ingl¨¦s; estar¨¢ dotado con un presupuesto de 1.000 millones de d¨®lares y cuenta con un consejo asesor del que forman parte, entre otros, el fundador de LinkedIn, Reid Hoffman; el antiguo presidente de Google, Eric Schmidt, y la antigua jefa de Yahoo, Marissa Mayer. Otros reconocidos inversores, empresarios y talentos, entre ellos Bill Gates, apoyan la iniciativa y le dar¨¢n respaldo y cobertura.

El objetivo es generar debates y estudios que no est¨¦n monopolizados por los t¨¦cnicos, y que ostenten autoridad acad¨¦mica y pol¨ªtica suficiente para dictar la ley en el desarrollo de la inteligencia artificial. Stanford, que ha destinado un gran edificio a este instituto, es su sede inevitable. Junto al MIT y Carnegie Mellon, Stanford representa la vanguardia en innovaci¨®n tecnol¨®gica y, espec¨ªficamente, en inteligencia artificial. El t¨¦rmino mismo fue acu?ado por John McCarthy, en 1955, en un laboratorio de Stanford.

¡°La inteligencia artificial ha provocado preguntas que tienen que ser contestadas por los economistas, por los fil¨®sofos, por los expertos en leyes¡±

Ahora, muchos a?os despu¨¦s, parece necesario sacar la inteligencia artificial de las manos de los ingenieros y los t¨¦cnicos. Es que el terreno de la inteligencia artificial ya no es solamente un espacio para la tecnolog¨ªa y la ciencia de computadores; es un terreno que abarca absolutamente todas las disciplinas intelectuales. Por eso creemos que en esta universidad tenemos una particular responsabilidad con la sociedad. Stanford es una universidad muy extensa: tenemos siete escuelas, todas muy fuertes, y existen muchas conexiones entre ellas. La inteligencia artificial ha despertado dudas, provocado preguntas a las que no pueden responder ¨²nicamente los cient¨ªficos de computadoras, los ingenieros y programadores, sino que tienen que ser contestadas por los economistas, por los fil¨®sofos, por los expertos en leyes¡ Nosotros sentimos que tenemos la obligaci¨®n de tratar de responder a esas preguntas, tenemos una larga tradici¨®n en esa ¨¢rea y por eso hemos decidido crear un gran instituto como este.

?Y qu¨¦ hace un fil¨®sofo en una aventura como esta? Efectivamente, soy un fil¨®sofo. Pero tambi¨¦n soy un l¨®gico [esa es su especialidad]. Y la l¨®gica es la m¨¢s t¨¦cnica de todas las disciplinas filos¨®ficas. Yo he estado de alguna forma vinculado a la inteligencia artificial pr¨¢cticamente desde que empec¨¦ mi actividad acad¨¦mica, en 1978. He asistido al desarrollo de ese sector. Yo no hago inteligencia artificial, pero la he visto crecer. Yo acepto la tecnolog¨ªa como una extraordinaria promesa, como una gran fuente de producci¨®n de beneficios para todos los individuos del planeta si la aplicamos de la forma correcta, si la aplicamos para solucionar los problemas adecuados. Al mismo tiempo, tiene un enorme potencial para hacer da?o, bien sea de manera intencionada o accidental. Ya existen casos en los que ciertos sistemas de inteligencia artificial han sido creados de forma discriminatoria contra un determinado grupo social, y de ah¨ª han partido decisiones discriminatorias sobre, por ejemplo, qui¨¦n puede tener acceso a un cr¨¦dito y qui¨¦n no.

?A qu¨¦ se refiere? Es muy simple para el empleado de un banco decirle a una familia: no les doy un cr¨¦dito porque mi computadora me ha dicho que no se lo d¨¦. Cada vez que usemos el data de forma discriminatoria, por cualquier raz¨®n, provocar¨¢ medidas concretas que mostrar¨¢n esa discriminaci¨®n y que perjudicar¨¢n o agravar¨¢n la situaci¨®n de un determinado segmento de la poblaci¨®n. Los datos pueden ser tan discriminatorios como el ser humano que los usa, pero con el agravante de que toda esta aura, toda esta admiraci¨®n ciega por la tecnolog¨ªa, nos hace pensar que las decisiones que toma un computador son muchos m¨¢s fiables que las que toma un individuo. Eso es un gran peligro.

Y supongo que eso es solo un ejemplo de peligros a¨²n mayores. Claro. Hay tecnolog¨ªa muy poderosa, como la tecnolog¨ªa nuclear, la biotecnolog¨ªa, que todos sabemos que puede ser utilizada para el bien, pero tambi¨¦n para el mal. Nuestro instituto est¨¢ dedicado a intentar que el lado bueno prevalezca sobre el lado malo.

¡°Cre¨ªmos que ten¨ªamos derecho a utilizar la tecnolog¨ªa de forma an¨®nima. Y eso ha llevado a todo este mundo de trols, odio y acoso que vemos en Internet¡±

?Nos estamos deshumanizando? ?Puede la inteligencia artificial destruir las cualidades que nos definen como seres humanos? Existe ese peligro, en efecto. No solo en relaci¨®n con la inteligencia artificial. Tambi¨¦n existe ese peligro en relaci¨®n con la tecnolog¨ªa de la comunicaci¨®n. Internet y las redes sociales son buenos ejemplos de tecnolog¨ªas que cuando las creamos no ¨¦ramos conscientes de los malos usos que podr¨ªan tener o de las malas consecuencias que pod¨ªan traer. Por poner un ejemplo: en un comienzo cre¨ªamos que, por supuesto, ten¨ªamos el derecho a utilizar la tecnolog¨ªa de forma an¨®nima. Se tom¨® la decisi¨®n colectiva de que tendr¨ªamos el derecho a comentar cualquier cosa sin necesidad de identificarnos. Y eso ha conducido a todo este mundo de trols, odio y acoso que vemos en Internet. Ese es un ejemplo de c¨®mo la tecnolog¨ªa tiene la capacidad de dividirnos y enfrentarnos como sociedad de muchas formas. Ahora, la inteligencia artificial puede resolver eso o puede agravarlo. Yo creo que m¨¢s bien puede agravarlo. De hecho, los robots en las redes sociales est¨¢n haciendo ya un enorme da?o. Lo que tenemos que hacer es que la tecnolog¨ªa sea ahora capaz de combatir ese mismo problema que ha creado, que sea capaz de identificar los robots que est¨¢n haciendo ese da?o y que la propia tecnolog¨ªa sea capaz de detenerlos.

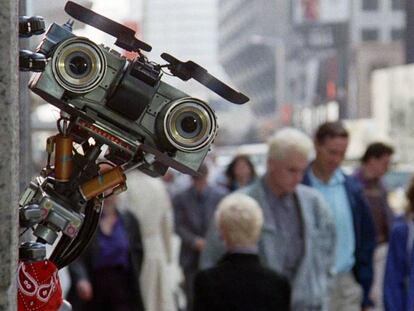

?Cu¨¢nto falta para que nos veamos rodeados de robots como los de las pel¨ªculas? Robots como los de las pe?l¨ªculas est¨¢n todav¨ªa muy, muy lejos. La gente que trabaja en inteligencia artificial o que observa y analiza la inteligencia artificial siempre ha infravalorado las dificultades de dar el siguiente paso. Pasar de donde estamos ahora a algo que se parezca a los robots que vemos en las pel¨ªculas supondr¨¢ d¨¦cadas. Previamente tenemos que decidir si queremos llegar a ellos. Podemos conseguir enormes beneficios de la inteligencia artificial sin tener que recrear jam¨¢s un modelo de inteligencia artificial similar a un ser humano. No es necesario. Tenemos un planeta lleno de seres humanos: ?para qu¨¦ queremos crear seres humanos artificiales? El objetivo se supone que es crear artefactos que nos permitan vivir mejor, que ayuden a los humanos de diferentes formas, a cumplir diferentes tareas.

?Pueden los robots llegar a tomar el poder? [Repite lentamente: ¡°?Pueden los robos tomar el poder?¡±.] Si lo hacen, ser¨¢ porque nosotros hemos hecho algo muy est¨²pido. Y espero que podamos prevenir eso, espero que seamos lo suficientemente inteligentes en el desarrollo de esa tecnolog¨ªa como para evitar ese futuro posible.

En cierto modo ya lo han hecho, ya dirigen nuestras vidas de forma muy significativa, ?no cree? Es verdad, est¨¢n tomando cierto control sobre nuestras vidas, pero no el poder. Los m¨®viles se han hecho muy adictivos, y ese es otro ejemplo de los riesgos que no tuvimos en cuenta cuando se desarroll¨® esa tecnolog¨ªa. La persona que dise?¨® el iPhone [Scott Forstall] fue un alumno m¨ªo. Me consta que nunca previ¨® lo importante que ese instrumento llegar¨ªa a ser en la vida de las personas. Estaba orgulloso, sab¨ªa que era un gran producto. Lo desarroll¨® de una forma muy secreta. Tanto que sol¨ªa contar que despu¨¦s, una vez puesto a la venta, cada vez que ve¨ªa a una persona con un iPhone, ¨¦l todav¨ªa se preguntaba: ¡°?Dios m¨ªo, ?c¨®mo lo ha conseguido?!¡±. En Apple sab¨ªan que ten¨ªan un gran producto, un artefacto capaz de realizar varias funciones. Si recuerdan la presentaci¨®n de Steve Jobs, dijo que el iPhone podr¨ªa hacer tres cosas: servir como un tel¨¦fono, dar acceso a Internet y reproducir m¨²sica. Pero la verdad ha sido que esto [se?ala al iPhone que graba la entrevista] no hace tres cosas, esto hace infinidad de cosas, ?y se ha convertido en una parte tan importante en nuestras vidas¡! Estoy convencido de que nadie anticip¨® eso.

?Cu¨¢les son los peligros de la inteligencia artificial directamente relacionados con la actividad pol¨ªtica? Obviamente, existe una preocupaci¨®n sobre la forma en que la inteligencia artificial ha afectado y puede afectar quiz¨¢s en ciertas campa?as electorales. Quiz¨¢s. De lo que estoy completamente convencido es de que es extremadamente importante que los pol¨ªticos entiendan la tecnolog¨ªa mucho mejor de lo que la entienden ahora, de tal forma que puedan tomar medidas importantes, las leyes adecuadas; no hablo de leyes intrusivas, pero s¨ª de leyes que gu¨ªen la tecnolog¨ªa por el buen camino y no por el malo. Esta es una de las funciones que quiere tener nuestra instituci¨®n: quiere ayudar a educar a la clase pol¨ªtica, quiere promover pol¨ªticas que son esenciales para que todo esto salga bien. El gobernador de California [Gavin Newson] estuvo con nosotros recientemente. Obviamente, California, donde gran parte de esta tecnolog¨ªa se desarrolla, est¨¢ muy preocupada por las consecuencias de todo esto, por su impacto en el mercado de trabajo, y ¨¦l nos pidi¨®: ¡°Por favor, aseg¨²rense de que el impacto de esto no resulte devastador para la poblaci¨®n de California¡±.

?Y qu¨¦ le contestaron? ?Qu¨¦ se puede hacer? No creemos que tengamos parte ni mucho menos la totalidad de las respuestas para las dudas que est¨¢ planteando la inteligencia artificial. A lo que nos hemos comprometido es a poner en marcha un proceso que permita resolver adecuadamente los problemas y elaborar pol¨ªticas correctas. Lo que podemos hacer como universidad, y como una universidad situada donde est¨¢ situada Stanford, es juntar a todos los involucrados en y por la inteligencia artificial: industria, Gobierno, pa¨ªses extranjeros, universidades¡ para abordar problemas y buscar las pol¨ªticas adecuadas, para buscar cu¨¢l es la forma de evitar hacer da?o a los negocios, a la econom¨ªa, y conseguir beneficios para el conjunto de la sociedad.

?Har¨¢n recomendaciones espec¨ªficas? S¨ª, haremos recomendaciones espec¨ªficas. Nuestra esperanza es conducir este proceso de una forma correcta y conseguir respuestas suficientes para elaborar, digamos, un libro blanco, algo que podamos sacar diciendo: as¨ª es como lo vemos. Para iluminar a los Gobiernos a tomar las medidas que permitan aprovechar los beneficios de la inteligencia artificial sin sufrir sus consecuencias negativas.?

Tu suscripci¨®n se est¨¢ usando en otro dispositivo

?Quieres a?adir otro usuario a tu suscripci¨®n?

Si contin¨²as leyendo en este dispositivo, no se podr¨¢ leer en el otro.

FlechaTu suscripci¨®n se est¨¢ usando en otro dispositivo y solo puedes acceder a EL PA?S desde un dispositivo a la vez.

Si quieres compartir tu cuenta, cambia tu suscripci¨®n a la modalidad Premium, as¨ª podr¨¢s a?adir otro usuario. Cada uno acceder¨¢ con su propia cuenta de email, lo que os permitir¨¢ personalizar vuestra experiencia en EL PA?S.

?Tienes una suscripci¨®n de empresa? Accede aqu¨ª para contratar m¨¢s cuentas.

En el caso de no saber qui¨¦n est¨¢ usando tu cuenta, te recomendamos cambiar tu contrase?a aqu¨ª.

Si decides continuar compartiendo tu cuenta, este mensaje se mostrar¨¢ en tu dispositivo y en el de la otra persona que est¨¢ usando tu cuenta de forma indefinida, afectando a tu experiencia de lectura. Puedes consultar aqu¨ª los t¨¦rminos y condiciones de la suscripci¨®n digital.