La visi¨®n artificial est¨¢ tuerta

Las t¨¦cnicas de an¨¢lisis y procesamiento de v¨ªdeo han vivido una revoluci¨®n en los ¨²ltimos cinco a?os, pero la falta de bases de datos frena el avance en este campo

Una mano derecha recoge un plato de la mesa y lo lleva a la encimera. Entonces aparece la izquierda, que ayuda a despegar dos trozos de pizza del papel de horno y entre las dos los dejan en el plato. Una vez all¨ª, los cortan y los pasan a un tupperware. Durante los siguientes nueve minutos el par de manos contin¨²a desempe?ando una pr¨¢ctica milenaria: recoger la cocina.

Hay mucho v¨ªdeo disponible, pero no hay etiquetas que describan esos contenidos Marcos Nieto, Vicomtech

"Cuando la gente trabaja en su cocina, hace multi-tasking de manera natural: lava platos mientras cocina, a?ade ingredientes mientras revuelve... Estas interacciones con objetivos paralelos nunca hab¨ªan sido capturadas en datasets egoc¨¦ntricos", explica Dima Damen, profesora asociada de visi¨®n artificial de la Universidad de Bristol. Estas son algunas de las peculiaridades que hacen ¨²nico el proyecto que lidera y que ha dado como resultado Epic Kitchens, el mayor dataset de v¨ªdeo egoc¨¦ntrico -grabado en primera persona, con una c¨¢mara en la frente- sin guion y con anotaciones que se ha recopilado jam¨¢s. Cuatro ciudades, 32 cocinas y 55 horas de grabaci¨®n.

Podr¨ªa parecer poco, pero es cinco veces la saga de El se?or de los anillos y viene a llenar la mil¨¦sima parte de un vac¨ªo que sufre toda la comunidad cient¨ªfica dedicada al an¨¢lisis y procesamiento de v¨ªdeo. "Hay mucho v¨ªdeo disponible -datos-, pero no hay etiquetas -metadatos- que describan esos contenidos. Si no hay metadatos, no tenemos ninguna forma de decirle a la m¨¢quina qu¨¦ est¨¢ ocurriendo", dice Marcos Nieto, investigador principal en Vicomtech.

Los sistemas de reconocimiento de imagen, que nunca hab¨ªan sido tan inteligentes, ampl¨ªan cada d¨ªa sus capacidades de detecci¨®n e identificaci¨®n de objetos. "Lo que todav¨ªa no est¨¢ resuelto, y queda mucho para lograrlo, son los procesamientos m¨¢s complejos, como la identificaci¨®n de acciones", se?ala Nieto. As¨ª, en una escena de Epic Kitchens, ser¨ªa m¨¢s sencillo obtener una lista de entidades, como fregona, clara, yema, servilletas, individuo enfadado... que la descripci¨®n de lo que est¨¢ ocurriendo: un huevo kamikaze se ha tirado de la encimera al suelo. "Ah¨ª los seres humanos todav¨ªa somos mucho mejores que las m¨¢quinas. Nosotros tenemos 20, 30, 40 a?os de entrenamiento, mientras que a las m¨¢quinas las podemos entrenar con una cantidad de im¨¢genes muy, muy inferior".

- Dos destinos y un problema

En Vicomtech necesitan estas fuentes de v¨ªdeos descritos para mejorar el reconocimiento de situaciones en tiempo real en sistemas de transporte. En Epic Kitchens quieren saberlo todo sobre nuestra manera de interactuar con el entorno. Convergen en la escasez de filmograf¨ªa que enturbia la mirada de sus sistemas de visi¨®n artificial, pero difieren en las soluciones propuestas.

El equipo de Nieto ha trabajado en desarrollar herramientas de deep learning que automaticen la interpretaci¨®n de grandes cantidades de v¨ªdeo. "Mientras se graba, se ejecutan algoritmos que van generando anotaciones de forma autom¨¢tica", precisa. Posteriormente, un equipo de anotadores revisa, valida y, en el peor de los casos, corrige las asociaciones propuestas. As¨ª, se rompe el c¨ªrculo vicioso donde las m¨¢quinas no aprenden porque no tienen libros y los libros no existen porque no hay m¨¢quinas capaces de crearlos; y se comienza a construir un c¨ªrculo virtuoso donde cada nuevo an¨¢lisis mejora aprendiendo de los errores detectados durante el anterior. "Ahora estamos centrados en escenarios de automoci¨®n, pero este mismo concepto podr¨ªa aplicarse pr¨¢cticamente a cualquier cosa", a?ade.

Epic Kitchens parte del producto completo: sus 55 horas de v¨ªdeo ya est¨¢n inequ¨ªvocamente procesadas y han resultado en la identificaci¨®n de nada menos que 39.594 segmentos de acci¨®n y 454.158 objetos. "En este momento, el mayor reto en el an¨¢lisis de v¨ªdeo egoc¨¦ntrico es que los datasets disponibles limitan la evaluaci¨®n de los m¨¦todos actuales", explica Damen. Su esperanza es que estos contenidos, que ya est¨¢n colgados en la web al alcance de cualquier ingeniero con acceso a internet, sirvan como base para comparar problemas y soluciones.

- Las ventajas de llevar una c¨¢mara en la frente

"La visi¨®n egoc¨¦ntrica ofrece puntos de vista ¨²nicos de los objetos mientras se est¨¢n usando", asegura Damen. Adem¨¢s, las actividades en la cocina resultan m¨¢s predecibles y orientadas a objetivos concretos que el curso de acci¨®n de quien se dedica a haraganear en el sal¨®n. "Creemos que una comprensi¨®n automatizada del v¨ªdeo egoc¨¦ntrico pondr¨¢ los cimientos para una interacci¨®n m¨¢s cautivadora entre humanos y ordenadores", promete la l¨ªder del proyecto.

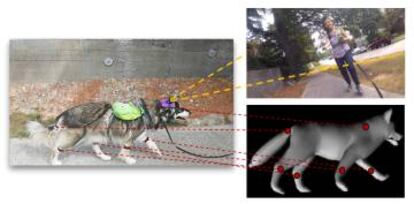

De hecho, el potencial del v¨ªdeo egoc¨¦ntrico ya ha cruzado la frontera del reino animal. Investigadores de la Universidad de Washington han compilado su propio dataset de v¨ªdeo egoc¨¦ntrico desde la perspectiva de un perro. Los modelos derivados del an¨¢lisis de estas nueve horas de v¨ªdeo son "prometedores", seg¨²n os autores del estudio. "Pueden predecir c¨®mo se mueve el perro en distintos escenarios y c¨®mo decidir¨¢ moverse de un estado a otro".

GDPR, ?otro tupido velo para la visi¨®n artificial?

La inminente nueva regulaci¨®n europea en materia de protecci¨®n de datos podr¨ªa complicar a¨²n m¨¢s la recopilaci¨®n de fuentes. "Exige que se pida permiso expl¨ªcito a cualquier persona antes de grabar sus datos. Hay una incompatibilidad directa entre el desarrollo de la tecnolog¨ªa y el de la regulaci¨®n", razona Nieto.

Para sortear el problema, utiliza un sistema de tratamiento de imagen que encripta cualquier informaci¨®n privada antes de que la imagen se guarde. "Solo en caso de que alg¨²n cuerpo de seguridad del Estado solicitase acceso, se le proporcionar¨ªa la clave para observar la imagen original", explica.

Tu suscripci¨®n se est¨¢ usando en otro dispositivo

?Quieres a?adir otro usuario a tu suscripci¨®n?

Si contin¨²as leyendo en este dispositivo, no se podr¨¢ leer en el otro.

FlechaTu suscripci¨®n se est¨¢ usando en otro dispositivo y solo puedes acceder a EL PA?S desde un dispositivo a la vez.

Si quieres compartir tu cuenta, cambia tu suscripci¨®n a la modalidad Premium, as¨ª podr¨¢s a?adir otro usuario. Cada uno acceder¨¢ con su propia cuenta de email, lo que os permitir¨¢ personalizar vuestra experiencia en EL PA?S.

En el caso de no saber qui¨¦n est¨¢ usando tu cuenta, te recomendamos cambiar tu contrase?a aqu¨ª.

Si decides continuar compartiendo tu cuenta, este mensaje se mostrar¨¢ en tu dispositivo y en el de la otra persona que est¨¢ usando tu cuenta de forma indefinida, afectando a tu experiencia de lectura. Puedes consultar aqu¨ª los t¨¦rminos y condiciones de la suscripci¨®n digital.