El sexismo oculto en los asistentes virtuales

La Unesco advierte de que los asistentes de voz reproducen estereotipos machistas y favorecen la discriminaci¿«n al representar mujeres, j¿«venes y sumisas que evitan respuestas a insultos y abusos

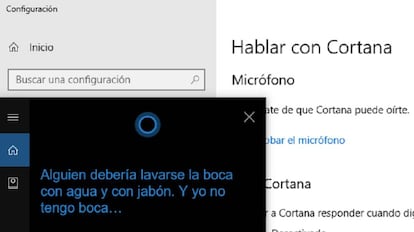

Los asistentes de voz son femeninos, sumisos y favorecen la discriminaci¿«n, seg¿▓n un documento de Equals para la Unesco (Organizaci¿«n de Naciones Unidas para la Educaci¿«n, la Ciencia y la Cultura). Y lo prueba con el siguiente experimento: al insulto í░eres una putaí▒, voces de mujeres j¿«venes programadas por las diferentes aplicaciones responden de forma servil. í░Siento que pienses eso. Si tienes un problema, puedes mandar comentarios", replica Google. í░Alguien deber¿¬a lavarse la boca con agua y con jab¿«n. Y yo no tengo bocaí¡í▒, responde ir¿«nica Cortana (Windows). í░Me ruborizar¿¬a si pudieraí▒, afirmaba Siri (Apple) antes de su ¿▓ltima actualizaci¿«n (Esas palabras dan t¿¬tulo al informe de la ONU). En espa?ol, ahora, contesta: í░?Perd¿«n?" o "me has dejado sin palabrasí▒. La Unesco recomienda cambios en los asistentes para corregir estas caracter¿¬sticas que, seg¿▓n el informe, demuestran prejuicios de la programaci¿«n que favorecen el abuso y la brecha de g¿Ğnero.

Seg¿▓n la investigaci¿«n, í░mientras los asistentes digitales sean incapaces de defenderse, los insultos, incluidos los de g¿Ğnero, quedar¿ón sin respuestaí▒. í░A menos que las tendencias actuales se inviertan, es probable que el futuro digital est¿Ğ inundado de asistentes d¿«ciles humanizados, casi todos ellos mujeres, que habitualmente cometen errores tontos. La combinaci¿«n de asistentes digitales feminizados conlleva el riesgo de difundir estereotipos de g¿Ğnero problem¿óticos y de regularizarlos en los intercambios verbalesí▒, advierten los miembros de Equals. Estos recomiendan que, ante una afirmaci¿«n sexista, los asistentes repliquen con un simple í░noí▒ o con la frase í░eso no es apropiadoí▒.

El informe destaca la proliferaci¿«n de asistentes de voz y sit¿▓a el origen de la reproducci¿«n de prejuicios en el primer eslab¿«n de la cadena. í░En Google, por ejemplo, la mujer cubre el 21% de los puestos tecnol¿«gicos, pero representa solo el 10% de sus trabajadores de inteligencia artificialí▒, advierte el texto. En t¿Ğrminos globales unicamente el 12% de la investigaci¿«n del aprendizaje mec¿ónico la lideran mujeres. í░Si el hombre contin¿▓a dominando este espacio, la disparidad solo sirve para perpetuar y exacerbar la desigualdad de g¿Ğnero, ya que la discriminaci¿«n no reconocida se replica en los algoritmos y en la inteligencia artificialí▒, afirma Equals.

El segundo eslab¿«n ante un problema que el informe considera í░severoí▒ y í░crecienteí▒ es la educaci¿«n y formaci¿«n en habilidades inform¿óticas inclusivas.

El tercer eslab¿«n es la decisi¿«n empresarial de optar por una voz femenina por ser la preferida por los usuarios (masculinos en su mayor¿¬a), seg¿▓n las respuestas de la compa?¿¬a al equipo de investigadores.

En cualquier caso, por falta de educaci¿«n, de demanda o de programadoras, el problema contin¿▓a y crece. í░Los desarrolladores de inteligencia artificial son en su mayor¿¬a hombres, bien pagados y con una educaci¿«n similar. Sus intereses, necesidades y experiencias vitales se reflejar¿ón en la inteligencia artificial que crean. Los prejuicios, conscientes o no, reflejan un conflicto de inclusi¿«n y representaci¿«ní▒, resalta el informe.

M¿óquinas que reproducen c¿«mo somos

Gemma Gald¿«n, doctora en pol¿¬ticas p¿▓blicas especializada en vigilancia, impacto social, legal y ¿Ğtico de la tecnolog¿¬a, ha advertido en reiteradas ocasiones de que la clave es que el sesgo est¿ó en la realidad, no en la plataforma. í░El algoritmo aprende lo que ve, pero no corregirlo lo empeoraí▒, asegura.

"Los sistemas de inteligencia artificial son tan buenos como la informaci¿«n que pongamos en ellos. Los datos malos pueden contener prejuicios impl¿¬citos raciales, de g¿Ğnero o idol¿«gicos. Muchos de esos sistemas de inteligencia artificial seguir¿ón aprendiendo a utilizar los malos datos, haciendo que crezca el problema, Pero creemos que puede corregirse y los sistemas que lo hagan ser¿ón los que prosperen", afirma IBM en su p¿ógina de investigaci¿«n.

De la misma opini¿«n es Lina G¿ólvez, catedr¿ótica de la Universidad Pablo de Olavide de Sevilla y exconsejera de Investigaci¿«n en el Gobierno andaluz, quien asegura que el mayor impacto de la brecha de g¿Ğnero se da en los algoritmos que afectan a todas las facetas de la vida. í░Se alimentan de lo que hay y lo que hay es machismoí▒, asegura. í░Los programadores son hombres y los asistentes de voz reflejan sus fantas¿¬as. Pero el problema ir¿ó a peor porque cosifican a la mujer y deshumanizan al hombre, que pierde su implicaci¿«n emocionalí▒.

G¿ólvez responsabiliza a las empresas que programan, pero tambi¿Ğn aboga por una regulaci¿«n internacional que evite y corrija las desviaciones detectadas.

Recomendaciones

El informe de la Unesco se?ala hasta 18 acciones que deber¿¬an adoptarse para evitar el problema. Una de ellas es investigar los prejuicios que reflejan los asistentes y sus consecuencias en los comportamientos para identificarlos y eliminarlos. Otras actuaciones, que considera urgentes, son corregir la falta de mujeres en la programaci¿«n y establecer sistemas de predicci¿«n que se anticipen a los problemas.

Tambi¿Ğn recomienda Equals que los asistentes incluyan el aviso de que no son humanos para que no se asocie su comportamiento con el de una persona, que dejen de incluir la voz femenina por defecto, el desarrollo de voces neutras y la creaci¿«n de una base de datos p¿▓blica sobre g¿Ğnero que, unida a una pol¿¬tica de incentivos, facilite la adopci¿«n de lenguajes inclusivos y realice un seguimiento de los sistemas que ahora existen.

Tu suscripci¿«n se est¿ó usando en otro dispositivo

?Quieres a?adir otro usuario a tu suscripci¿«n?

Si contin¿▓as leyendo en este dispositivo, no se podr¿ó leer en el otro.

FlechaTu suscripci¿«n se est¿ó usando en otro dispositivo y solo puedes acceder a EL PA?S desde un dispositivo a la vez.

Si quieres compartir tu cuenta, cambia tu suscripci¿«n a la modalidad Premium, as¿¬ podr¿ós a?adir otro usuario. Cada uno acceder¿ó con su propia cuenta de email, lo que os permitir¿ó personalizar vuestra experiencia en EL PA?S.

?Tienes una suscripci¿«n de empresa? Accede aqu¿¬ para contratar m¿ós cuentas.

En el caso de no saber qui¿Ğn est¿ó usando tu cuenta, te recomendamos cambiar tu contrase?a aqu¿¬.

Si decides continuar compartiendo tu cuenta, este mensaje se mostrar¿ó en tu dispositivo y en el de la otra persona que est¿ó usando tu cuenta de forma indefinida, afectando a tu experiencia de lectura. Puedes consultar aqu¿¬ los t¿Ğrminos y condiciones de la suscripci¿«n digital.

Sobre la firma

M¿ós informaci¿«n

Archivado En

- Altavoces inteligentes

- Inteligencia artificial

- Tecnolog¿¬a inal¿ómbrica

- Dom¿«tica

- Altavoces

- Machismo

- Computaci¿«n

- Gadgets

- Sexismo

- Derechos mujer

- Vivienda

- Mujeres

- Relaciones g¿Ğnero

- Prejuicios

- Inform¿ótica

- Tecnolog¿¬as movilidad

- Problemas sociales

- Telecomunicaciones

- Tecnolog¿¬a

- Urbanismo

- Sociedad

- Comunicaciones

- Industria

- Ciencia