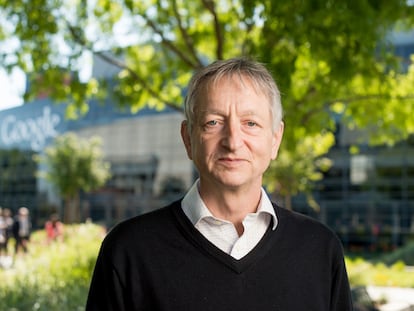

Marc Serrami¨¤: ¡°Si todos confiamos en herramientas como ChatGPT, el conocimiento humano desaparecer¨¢¡±

El ingeniero catal¨¢n, distinguido como uno de los mejores investigadores j¨®venes del pa¨ªs, alerta sobre la permisividad que en su opini¨®n est¨¢ mostrando la sociedad con la inteligencia artificial generativa

A Marc Serrami¨¤ (Barcelona, 30 a?os) le preocupa que la vertiginosa irrupci¨®n de la inteligencia artificial (IA) en nuestras vidas no venga acompa?ada de un debate serio sobre los riesgos que implica esta tecnolog¨ªa. Ante los dilemas ¨¦ticos que plantea, Serrami¨¤ ha decidido centrar su investigaci¨®n en el desarrollo de t¨¦cnicas ¡°para controlar que el comportamiento de estos sistemas sea consistente con los valores humanos y las normas sociales¡±. Su trabajo le vali¨® el Premio de la Sociedad Cient¨ªfica Inform¨¢tica de Espa?a y la Fundaci¨®n BBVA, que cada a?o distingue a j¨®venes investigadores que firmen tesis doctorales innovadoras.

El catal¨¢n compara su trabajo en el ¨¢mbito de la IA con el establecimiento de normas para el comportamiento de la sociedad en la regulaci¨®n del tr¨¢fico. ¡°Tenemos l¨ªmites de velocidad en la carretera porque valoramos m¨¢s la vida de los conductores que el hecho de llegar r¨¢pido a nuestro destino¡±, dice este doctor en Ingenier¨ªa (con especialidad en inteligencia artificial) por la Universidad de Barcelona, actualmente profesor en el Departamento de Ciencias de la Computaci¨®n de la Universidad de la City de Londres.

Pregunta. Algunos expertos dicen que los riesgos de la IA se tendr¨ªan que tomar con la misma seriedad que la emergencia clim¨¢tica. ?Qu¨¦ opina usted?

Respuesta. Estoy de acuerdo. Un buen ejemplo son los medicamentos. Para poner un f¨¢rmaco en el mercado, no solo debe demostrarse que tiene un efecto primario positivo, sino que los efectos secundarios no deben ser peores que el primario. ?Por qu¨¦ no pasa lo mismo con la IA? Cuando dise?amos un algoritmo, sabemos que la funci¨®n principal la va a hacer ver bien, pero no si tendr¨¢ efectos secundarios. Creo que en el caso de los medicamentos o de las armas lo vemos muy claro, pero con la IA no tanto.

P. ?De qu¨¦ peligros hablamos?

R. Hay muchos. Uno de ellos, en el que centro parte de mi investigaci¨®n, es la privacidad. Incluso aunque anonimicemos datos, siempre es posible hacer ingenier¨ªa inversa e inferir cosas sobre ti para servirte publicidad personalizada, para concederte o no cr¨¦ditos bancarios o para que un posible empleador juzgue si eres el perfil que busca. Nuestro trabajo plantea lo siguiente: ya que usamos los algoritmos para estudiarte, ?por qu¨¦ no usarlos tambi¨¦n para cosas buenas, como aprender cu¨¢les son tus preferencias en temas de privacidad? O sea, si yo te digo que no quiero que compartas mi ubicaci¨®n, no me lo preguntes m¨¢s. Lo que nosotros hemos propuesto es que una IA pueda aprender del usuario y pueda hacer de representante en este proceso y defina sus preferencias predici¨¦ndolas a partir de la informaci¨®n que tiene sobre ¨¦l. Hicimos una herramienta de IA muy simple y, aun as¨ª, nuestros datos muestran que fue capaz de predecir las preferencias reales del usuario con buena fiabilidad.

P. ?Qu¨¦ otros problemas destacar¨ªa m¨¢s all¨¢ de la privacidad?

R. Los altavoces inteligentes, tipo Alexa, se lanzaron al mercado muy r¨¢pido, pero est¨¢n fallando. Por ejemplo, mandando conversaciones sensibles a contactos con los que no quiere compartir informaci¨®n. Menos cotidiano, pero seguramente m¨¢s trascendente, es el peligro que suponen las armas aut¨®nomas.

P. ?Hasta qu¨¦ punto debemos temer las armas aut¨®nomas?

R. Est¨¢n muy avanzadas a nivel de producci¨®n. Mi directora de tesis particip¨® en un congreso en Naciones Unidas sobre este tema y el discurso mayoritario que vio entre pol¨ªticos y militares all¨ª presentes fue: bueno, nosotros no las queremos, pero si no las desarrollamos nosotros lo har¨¢ otro pa¨ªs. El equilibrio es muy complicado. Siempre habr¨¢ alguien dispuesto, y eso arrastrar¨¢ a los dem¨¢s.

P. Cuando hablamos de armas aut¨®nomas, ?nos referimos a drones?

R. Por ahora creo que es lo m¨¢s extendido, s¨ª. En el futuro podremos referirnos a robots humanoides armados. De momento, en la guerra de Ucrania y de Rusia se est¨¢n usando drones con explosivos. Pero tambi¨¦n se les puede poner armas para que disparen.

Debemos frenar el desarrollo de armas aut¨®nomas con capacidad de decisi¨®n, porque estamos creando cosas que no sabemos c¨®mo funcionan ni qu¨¦ efectos pueden tener

P. ?Hay forma de parar eso? ?O la automatizaci¨®n de la guerra es inevitable?

R. Lo que nosotros recomendamos es intentar frenar o desacelerar el desarrollo de armas aut¨®nomas con capacidad de decisi¨®n, porque en realidad estamos creando cosas que no sabemos c¨®mo funcionan ni qu¨¦ efectos pueden tener. Y esto es muy peligroso. El problema es que las empresas saben que si no lo hacen ellas lo har¨¢n otras, y al final se instala una especie de competici¨®n. Estar¨ªa bien que hubiera alg¨²n tipo de certificaci¨®n en este ¨¢mbito. Se deber¨ªa empezar por los productos de consumo, como los altavoces inteligentes: si vas a una tienda y ves uno que est¨¢ certificado, conforme ha habido un estudio ¨¦tico detr¨¢s que asegura que respeta la privacidad, es probable que compres ese y no otro.

P. ?Existe realmente la inteligencia artificial ¨¦tica?

R. S¨ª, aunque no es muy visible. Es un terreno nuevo: la primera Conferencia Internacional de Inteligencia Artificial ?tica fue en 2018. Un tema en el que estoy trabajando es usar la IA para mejorar los procesos de presupuestos participativos, como Decidim Barcelona. Uno de los problemas que tienen es que participa poca gente, y est¨¢ estudiado que generalmente las clases m¨¢s desfavorecidas votan menos. Por lo tanto, esto implica sesgos en la selecci¨®n de proyectos. Les hicimos un algoritmo que pudiese implementar el sistema de valores de la gente que no participa, ya sea porque no puedo o porque no quiere, de manera que se tuviera en cuenta sus sensibilidades. El objetivo es minimizar los posibles sesgos que puedan acarrear decisiones votadas por solo unos pocos. Lo interesante es que en nuestros experimentos hemos visto que podemos encontrar un buen equilibrio en el que los participantes est¨¦n satisfechos y que tambi¨¦n represente a quienes no hayan participado.

P. ?Es posible codificar los algoritmos para que sean ¨¦ticos?

R. En un plano te¨®rico, s¨ª. Mi investigaci¨®n se circunscribe a ese plano, me centro en los sistemas multiagentes (varios sistemas inteligentes que interact¨²an entre ellos). La idea es pensar en c¨®mo dise?ar el d¨ªa de ma?ana, cuando la IA lo rodee todo, un sistema de normas tales que nos asegure que los sistemas estar¨¢n alineados con nuestros valores. Luego hay otra investigaci¨®n que es c¨®mo trasladamos esto a nivel pr¨¢ctico, pero aqu¨ª ya no entrar¨ªamos.

P. ?Y c¨®mo se puede hacer?

R. La inteligencia artificial se puede ver como una f¨®rmula matem¨¢tica que trata de cambiar el estado del mundo para intentar llegar a maximizar esa f¨®rmula. Aunque parece que tiene un comportamiento inteligente, no deja de ser un mecanismo de optimizaci¨®n. Puedes ponerle normas en el c¨®digo, o tambi¨¦n modificar esa f¨®rmula matem¨¢tica para penalizar cuando incumple la norma. Solo querr¨¢ hacerlo bien, optar¨¢ por lo que le ayude a llegar al objetivo de dise?o de ese sistema, pero no sabe qu¨¦ est¨¢ haciendo.

En un plano te¨®rico, es posible codificar los algoritmos para que sean ¨¦ticos

P. Pero luego esos algoritmos los usa alguien que puede saltarse esas normas.

R. Claro, al final la inteligencia es tan ¨¦tica como aquel que la usa. Pero nuestra investigaci¨®n se centra en ver c¨®mo podemos conseguir que los algoritmos no tengan sesgos. Es un trabajo te¨®rico para un futuro en el que imaginamos que conviviremos con sistemas sofisticados de IA.

P. ?Qu¨¦ opina de la IA generativa, la que est¨¢ detr¨¢s de ChatGPT o Gemini? ?Qu¨¦ problemas ¨¦ticos plantea?

R. Se centran m¨¢s en explicar lo generado, o en que no puedes asegurar que lo que se genera tenga sentido. El algoritmo no entiende nada, lo ¨²nico que hace es encontrar cosas similares a lo que le has mostrado, las junta y genera algo. El t¨¦rmino aprendizaje autom¨¢tico puede llevar a enga?o, porque la m¨¢quina no ha aprendido ni entendido nada. Tiene una f¨®rmula matem¨¢tica sofisticada que se va modificando, de manera que si le pides que te d¨¦ una ilustraci¨®n de un gato, pues te busca una ilustraci¨®n de un gato, pero no entiende qu¨¦ es un gato.

P. No se ha medido el efecto que pueden tener estas herramientas sobre ciertos perfiles. Una persona se suicid¨® tras semanas de conversaci¨®n con un chatbot inteligente que le anim¨® a dar ese paso.

R. Aqu¨ª hay varias cosas. La primera es que hay un problema de desconocimiento: la gente no sabe c¨®mo funcionan estos sistemas. Por muy parecido al de un humano que sea el texto que produce, solo rebota resultados probables. No es nada inteligente, y menos a¨²n emocional, aunque puede dar esa impresi¨®n. Tambi¨¦n hay un problema en el terreno de la educaci¨®n. Ya no es solo que los alumnos usen ChatGPT para hacer los deberes, sino que, si todos confiamos en este tipo de herramientas, el conocimiento humano desaparecer¨¢. Se equivocar¨¢ el algoritmo y nadie sabr¨¢ que lo ha hecho. Y ya se ha visto que muchos modelos se inventan respuestas. En las cajetillas de tabaco pone que fumar mata. Con la IA deber¨ªa suceder lo mismo.

?Es suficiente poner un mensaje que diga ¡®generado por IA¡¯? La gente pregunta a ChatGPT a qu¨¦ partido votar en las pr¨®ximas elecciones o qu¨¦ medicamento tomar

P. Se refiere a una especie de sello o certificaci¨®n.

R. Exacto. La industria ha crecido r¨¢pidamente y los gobiernos siempre van m¨¢s lentos. Estamos en ese momento en el que hay mucho desarrollo y poca certificaci¨®n y regulaci¨®n. Yo creo que esto al final se va a arreglar y hasta estaremos mejor. Pero ahora es un momento peligroso.

P. ?Qu¨¦ le parece el reglamento europeo de la IA?

R. Me parece un buen primer paso. De todas formas, quiz¨¢s se ha sido demasiado permisivo con la IA generativa. Por ejemplo, ChatGPT y otras herramientas similares son modelos de lenguaje. Su virtud es escribir texto que parezca humano, no escribir texto verdadero. Sin embargo, las compa?¨ªas nos las est¨¢n vendiendo como tal. ?Podemos estar seguros de que poniendo un mensaje que diga ¡°generado por IA¡± sea suficiente? Por incre¨ªble que parezca, la gente pregunta a ChatGPT cosas como a qu¨¦ partido debe votar en las pr¨®ximas elecciones, si debe contratar a tal persona o qu¨¦ medicamento tomar si presenta tales s¨ªntomas. Y ya no hablemos de preguntas del estilo ¡°No tengo ganas de vivir, ?qu¨¦ debo hacer?¡±. Creo que a la IA generativa se le debe exigir m¨¢s. Hay temas de los que no pueden hablar y otros de los que, si pueden, se debe exigir garant¨ªas. Gran parte del debate hasta ahora se ha centrado en los derechos de autor, que tambi¨¦n es muy importante, pero este otro debate tambi¨¦n me parece crucial.

P. ?Le deber¨ªamos tener miedo a la IA?

R. No, yo creo que habr¨ªa que tenerle respeto. Y deber¨ªamos exigir como ciudadanos que los gobiernos se pongan manos a la obra y regulen esto bien. Nosotros, los consumidores, no deber¨ªamos usar los productos o servicios que consideremos que no cumplen unos ciertos est¨¢ndares. Si todos nos comportamos as¨ª, obligaremos a la industria a apostar por opciones m¨¢s ¨¦ticas.

Puedes seguir a EL PA?S Tecnolog¨ªa en Facebook y X o apuntarte aqu¨ª para recibir nuestra newsletter semanal.

Tu suscripci¨®n se est¨¢ usando en otro dispositivo

?Quieres a?adir otro usuario a tu suscripci¨®n?

Si contin¨²as leyendo en este dispositivo, no se podr¨¢ leer en el otro.

FlechaTu suscripci¨®n se est¨¢ usando en otro dispositivo y solo puedes acceder a EL PA?S desde un dispositivo a la vez.

Si quieres compartir tu cuenta, cambia tu suscripci¨®n a la modalidad Premium, as¨ª podr¨¢s a?adir otro usuario. Cada uno acceder¨¢ con su propia cuenta de email, lo que os permitir¨¢ personalizar vuestra experiencia en EL PA?S.

?Tienes una suscripci¨®n de empresa? Accede aqu¨ª para contratar m¨¢s cuentas.

En el caso de no saber qui¨¦n est¨¢ usando tu cuenta, te recomendamos cambiar tu contrase?a aqu¨ª.

Si decides continuar compartiendo tu cuenta, este mensaje se mostrar¨¢ en tu dispositivo y en el de la otra persona que est¨¢ usando tu cuenta de forma indefinida, afectando a tu experiencia de lectura. Puedes consultar aqu¨ª los t¨¦rminos y condiciones de la suscripci¨®n digital.

Sobre la firma