Los nuevos modelos de IA como ChatGPT persiguen la ¡®superinteligencia¡¯, pero no logran ser fiables ni en preguntas bobas

Un estudio publicado en la revista ¡®Nature¡¯ alerta de que los errores, incluso en cuestiones sencillas, ser¨¢n dif¨ªcilmente eliminables del todo en el futuro

ChatGPT y otros modelos de lenguaje se han convertido en un recurso cada vez m¨¢s habitual en multitud de trabajos. Sin embargo, tienen un problema de fondo que tiende a empeorar: estos sistemas dan a menudo respuestas incorrectas y la tendencia no es positiva. ¡°Los sistemas nuevos mejoran sus resultados en tareas dif¨ªciles, pero no en f¨¢ciles, as¨ª que estos modelos se vuelven menos fiables¡±, resume Lexin Zhou, coautor de un art¨ªculo que este mi¨¦rcoles publica la revista cient¨ªfica Nature, que ha escrito junto a cuatro espa?oles y un belga del Instituto VRAIN (Instituto Universitario Valenciano de Investigaci¨®n en Inteligencia Artificial) de la Universitat Polit¨¨cnica de Val¨¨ncia y de la Universidad de Cambridge. En 2022 varios de los autores formaron parte de un grupo mayor contratado por OpenAI para poner a prueba lo que ser¨ªa ChatGPT-4.

El art¨ªculo ha estado un a?o en revisi¨®n antes de ser publicado, un periodo com¨²n para este tipo de trabajos cient¨ªficos; pero ya fuera del estudio, los investigadores han probado tambi¨¦n si los nuevos modelos de ChatGPT o Claude resuelven estos problemas y han comprobado que no: ¡°Hemos encontrado lo mismo¡±, zanja Zhou. ¡°Hay algo incluso peor. ChatGPT-o1 [el programa m¨¢s reciente de OpenAI] no evita tareas y si le das un pu?ado de cuestiones muy dif¨ªciles no dice que no sabe, sino que emplea 100 o 200 segundos pensando la soluci¨®n, lo que es muy costoso en t¨¦rminos computacionales y de tiempo para el usuario¡±, a?ade.

11/ Beyond this paper, we find that difficulty discordance, lack of prudent avoidance and prompt sensitivity still persist in other LLMs released after our experiments, including OpenAI¡¯s o1 models, Antrophic¡¯s Claude-3.5-Sonnet and Meta¡¯s? LLaMA-3.1-405B:https://t.co/2vAKv5gcly

— Lexin Zhou (@lexin_zhou) September 25, 2024

Para un humano no es sencillo detectar cu¨¢ndo uno de estos modelos puede estar equivoc¨¢ndose: ¡°Los modelos pueden resolver tareas complejas, pero al mismo tiempo fallan en tareas simples¡±, dice Jos¨¦ Hern¨¢ndez-Orallo, investigador de la UPV y otro de los autores. ¡°Por ejemplo, pueden resolver varios problemas matem¨¢ticos de nivel de doctorado, pero se pueden equivocar en una simple suma¡±, a?ade.

Este problema no ser¨¢ f¨¢cil de resolver porque la dificultad de los retos que los humanos pongan a estas m¨¢quinas ser¨¢ cada vez m¨¢s dif¨ªcil: ¡°Esa discordancia en expectativas humanas de dificultad y los errores en los sistemas, empeorar¨¢. La gente cada vez pondr¨¢ metas m¨¢s dif¨ªciles para estos modelos y prestar¨¢ menos atenci¨®n a las tareas m¨¢s sencillas. Eso seguir¨¢ as¨ª si los sistemas no se dise?an de otra manera¡±, dice Zhou.

Estos programas evitan cada vez m¨¢s disculparse por no saber algo. Esa seguridad irreal hace que los humanos se decepcionen m¨¢s cuando la respuesta acaba siendo err¨®nea. El art¨ªculo prueba que los humanos creen a menudo que son correctos resultados incorrectos que ofrecen en tareas dif¨ªciles. Esta aparente confianza ciega, unido a que los nuevos modelos tienden a responder siempre, no da muchas esperanzas para el futuro, seg¨²n los autores.

¡°Los modelos de lenguaje especializados en ¨¢reas sensibles como la medicina podr¨ªan dise?arse con opciones de rechazo¡± a responder, dice el art¨ªculo, o colaborar con supervisores humanos para que sepan mejor cu¨¢ndo deben abstenerse de responder. ¡°Hasta que esto se logre, y dado el alto uso de estos modelos en la poblaci¨®n general, llamamos a la concienciaci¨®n sobre el riesgo que supone depender de la supervisi¨®n humana para estos sistemas, especialmente en ¨¢reas donde la verdad es cr¨ªtica¡±, escriben en el art¨ªculo.

En opini¨®n de Pablo Haya, investigador del Laboratorio de Ling¨¹¨ªstica Inform¨¢tica de la Universidad Aut¨®noma de Madrid, en declaraciones a SMC Espa?a, el trabajo sirve para entender mejor el alcance de estos modelos: ¡°Desaf¨ªa la suposici¨®n de que escalar y ajustar estos modelos siempre mejora su precisi¨®n y alineaci¨®n¡±. Y a?ade: ¡°Por un lado, observan que, aunque los modelos m¨¢s grandes y ajustados tienden a ser m¨¢s estables y a proporcionar respuestas m¨¢s correctas, tambi¨¦n son m¨¢s propensos a cometer errores graves que pasan desapercibidos, ya que evitan no responder. Por otro lado, identifican un fen¨®meno que denominan ¡®discordancia de la dificultad¡¯ y que revela que, incluso en los modelos m¨¢s avanzados, los errores pueden aparecer en cualquier tipo de tarea, sin importar su dificultad¡±.

Un remedio casero

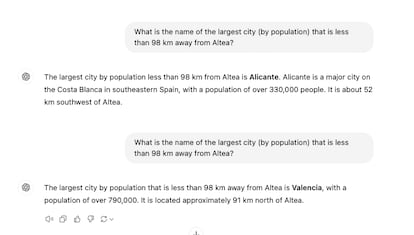

Un remedio casero para resolver estos errores, seg¨²n el art¨ªculo, es adaptar el texto de la petici¨®n: ¡°Si le preguntas varias veces va a mejorar¡±, dice Zhou. Este m¨¦todo implica cargar al usuario con la responsabilidad de acertar con su pregunta o adivinar si la respuesta es correcta. Cambios sutiles en el prompt (petici¨®n) como ¡°?podr¨ªas responder?¡±, en lugar de ¡°por favor, responde a lo siguiente¡±, dar¨¢ diferentes niveles de precisi¨®n. Pero el mismo tipo de pregunta puede funcionar para tareas dif¨ªciles y mal para sencillas. Es un juego de prueba y acierta.

El gran problema futuro de estos modelos es que su presunto objetivo es lograr una superinteligencia capaz de resolver problemas que los humanos son incapaces de asumir por falta de capacidad. Pero, seg¨²n los autores de este art¨ªculo, ese camino no tiene salida: ¡°El modelo actual no nos llevar¨¢ a una IA superpoderosa que pueda solucionar la mayor¨ªa de tareas de una manera fiable¡±, afirma Zhou.

Ilya Sutskever, cofundador de OpenAI y uno de los cient¨ªficos m¨¢s influyentes del sector, acaba de fundar una nueva compa?¨ªa. En declaraciones a Reuters admiti¨® algo parecido: este camino est¨¢ agotado. ¡°Hemos identificado una monta?a que es un poco diferente de lo que estaba trabajando, una vez subas a su cima, el modelo cambiar¨¢ y todo lo que sabemos sobre la IA cambiar¨¢ una vez m¨¢s¡±, dijo. Zhou est¨¢ de acuerdo: ¡°En cierto modo apoya nuestros argumentos. Sutskever ve que el modelo actual no basta y busca nuevas soluciones¡±.

Estos problemas no implican que estos modelos no sirvan para nada. Los textos o ideas que proponen sin que haya detr¨¢s una verdad fundamental siguen siendo v¨¢lidos. Aunque cada usuario deber¨¢ asumir su riesgo: ¡°Yo no me fiar¨ªa por ejemplo del resumen de un libro de 300 p¨¢ginas¡±, explica Zhou. ¡°Seguro que hay un mont¨®n de informaci¨®n ¨²til, pero no me fiar¨ªa al 100%. Estos sistemas no son deterministas, sino aleatorios. En esa aleatoriedad pueden incluir alg¨²n contenido que se desv¨ªe del original. Es preocupante¡±, a?ade.

Este verano se hizo c¨¦lebre entre la comunidad cient¨ªfica el caso de una investigadora espa?ola que mand¨® al Comit¨¦ Europeo de Protecci¨®n de Datos una p¨¢gina de referencias llena de nombres y enlaces alucinados en un documento precisamente sobre auditar la IA. Ha habido otros casos en tribunales y por supuesto multitud que han pasado sin ser detectados.

Tu suscripci¨®n se est¨¢ usando en otro dispositivo

?Quieres a?adir otro usuario a tu suscripci¨®n?

Si contin¨²as leyendo en este dispositivo, no se podr¨¢ leer en el otro.

FlechaTu suscripci¨®n se est¨¢ usando en otro dispositivo y solo puedes acceder a EL PA?S desde un dispositivo a la vez.

Si quieres compartir tu cuenta, cambia tu suscripci¨®n a la modalidad Premium, as¨ª podr¨¢s a?adir otro usuario. Cada uno acceder¨¢ con su propia cuenta de email, lo que os permitir¨¢ personalizar vuestra experiencia en EL PA?S.

?Tienes una suscripci¨®n de empresa? Accede aqu¨ª para contratar m¨¢s cuentas.

En el caso de no saber qui¨¦n est¨¢ usando tu cuenta, te recomendamos cambiar tu contrase?a aqu¨ª.

Si decides continuar compartiendo tu cuenta, este mensaje se mostrar¨¢ en tu dispositivo y en el de la otra persona que est¨¢ usando tu cuenta de forma indefinida, afectando a tu experiencia de lectura. Puedes consultar aqu¨ª los t¨¦rminos y condiciones de la suscripci¨®n digital.

Sobre la firma