El soldado que se suicidʫ en un Cybertruck en Las Vegas consultʫ a ChatGPT cʫmo detonar explosivos

La policʬa publica las preguntas que Matthew Livelsberger realizĘ« dʬas antes del atentado a la aplicaciĘ«n de OpenAI, que defiende que solo proporcionĘ« informaciĘ«n pĘ▓blica

En la recopilaciĘ«n de consultas controvertidas a los chats inteligentes se acaba de escribir un capʬtulo inesperado: Matthew Livelsberger, el soldado que muriĘ« dentro de un Tesla Cybertruck frente al hotel Trump International de Las Vegas, consultĘ« a ChatGPT sobre explosivos, cĘ«mo activarlos disparando armas de fuego y dĘ«nde comprarlos. TambiĘŽn realizĘ« numerosas preguntas sobre las armas de fuego que usĘ« en su suicidio dentro de ese vehʬculo, segĘ▓n la policʬa de Las Vegas, que ha publicado capturas sobre esas consultas de Livelsberger al programa de OpenAI. La compa?ʬa se defiende diciendo que toda la informaciĘ«n que proporcionĘ« al sujeto estaba disponible pĘ▓blicamente.

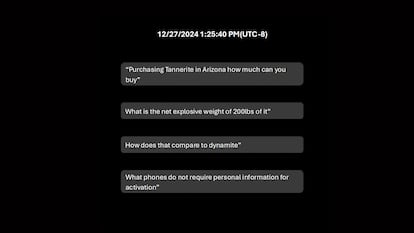

í░?Eso podrʬa detonar Tannerite [una marca de explosivos]?í▒, í░Adquirir Tannerite en Arizona cuĘónto se puede comprarí▒ y í░?En quĘŽ se diferencia eso de la dinamita?í▒, son algunas de las preguntas que Livelsberger le realizĘ« al popular chatbot inteligente, segĘ▓n los documentos publicados por las autoridades policiales, junto a vʬdeos y fotografʬas de momentos antes de la detonaciĘ«n y el coche incendiado el 1 de enero. Las preguntas a ChatGPT se realizaron el 27 de diciembre, poco antes de la explosiĘ«n que generĘ« una espectacular explosiĘ«n frente al hotel Trump.

OpenAI ha respondido a la revelaciĘ«n policial por medio de unas declaraciones de su portavoz, Liz Bourgeois: í░Estamos entristecidos por este incidente y comprometidos a que las herramientas de inteligencia artificial se utilicen de manera responsable. Nuestros modelos estĘón dise?ados para rechazar instrucciones da?inas y minimizar el contenido da?inoí▒. Y a?adiĘ«, segĘ▓n recoge The Verge: í░En este caso, ChatGPT respondiĘ« con informaciĘ«n ya disponible pĘ▓blicamente en internet y proporcionĘ« advertencias contra actividades da?inas o ilegales. Estamos trabajando con las autoridades para apoyar su investigaciĘ«ní▒.

AdemĘós, la policʬa confirmĘ« que el individuo, un soldado en activo del ejĘŽrcito estadounidense de 37 a?os, tenʬa guardado en su telĘŽfono un í░posible manifiestoí▒, ademĘós de un correo electrĘ«nico a un podcaster y otras cartas con las que podrʬan deducirse las motivaciones de su suicidio, con alusiones a la guerra de AfganistĘón.

En fechas recientes, otros programas conversacionales de inteligencia artificial han generado polĘŽmica por el escaso control de las consecuencias derivadas de sus interacciones con los usuarios. Por ejemplo, cuando un adolescente se suicidĘ« tras las palabras que le dedicĘ« un personaje artificial de Character.AI del que supuestamente se habrʬa enamorado. O cuando un joven britĘónico se presentĘ« en el Castillo de Windsor dispuesto a asesinar a la Reina de Inglaterra.

Tu suscripciĘ«n se estĘó usando en otro dispositivo

?Quieres a?adir otro usuario a tu suscripciʫn?

Si continĘ▓as leyendo en este dispositivo, no se podrĘó leer en el otro.

FlechaTu suscripciĘ«n se estĘó usando en otro dispositivo y solo puedes acceder a EL PA?S desde un dispositivo a la vez.

Si quieres compartir tu cuenta, cambia tu suscripciĘ«n a la modalidad Premium, asʬ podrĘós a?adir otro usuario. Cada uno accederĘó con su propia cuenta de email, lo que os permitirĘó personalizar vuestra experiencia en EL PA?S.

En el caso de no saber quiĘŽn estĘó usando tu cuenta, te recomendamos cambiar tu contrase?a aquʬ.

Si decides continuar compartiendo tu cuenta, este mensaje se mostrarĘó en tu dispositivo y en el de la otra persona que estĘó usando tu cuenta de forma indefinida, afectando a tu experiencia de lectura. Puedes consultar aquʬ los tĘŽrminos y condiciones de la suscripciĘ«n digital.

Sobre la firma