Machistas, sexistas, sordas o ciegas: cuando las herramientas solo sirven a quien las dise?a

El dise?o de nuestro entorno sigue teniendo un sesgo racial y de g¨¦nero que, frecuentemente, est¨¢ hecho a la medida del hombre blanco de mediana edad. Ox¨ªmetros calibrados para pieles claras, dispositivos de asistencia card¨ªaca ajustados para varones o sistemas de reconocimiento facial que fallan ante ojos rasgados son algunos ejemplos

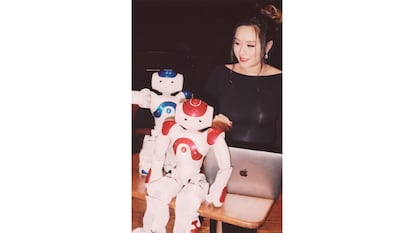

Carol Reiley, emprendedora inform¨¢tica, pionera en el desarrollo de aplicaciones de conducci¨®n aut¨®noma y cirug¨ªa robotizada, lo tiene claro: ¡°El dise?o sesgado, el mal dise?o, es muy a menudo cuesti¨®n de vida o muerte¡±. En un art¨ªculo para la revista tecnol¨®gica Tech Crunch, Reiley, toda una autoridad mundial en su campo, cuenta que ya en sus a?os universitarios, en la d¨¦cada de 2000, ella desarroll¨® un prototipo de robot quir¨²rgico que recib¨ªa ¨®rdenes a trav¨¦s del sistema de reconocimiento de voz de Microsoft, por entonces puntero. ¡°Por incre¨ªble que parezca, aquel sistema no reconoc¨ªa mi voz. Hab¨ªa sido dise?ado por un equipo de hombres de entre 20 y 30 a?os y no era capaz de procesar el tono en general m¨¢s agudo de las voces femeninas¡±. No era apto, en fin, para el 51% de los habitantes del planeta.

Para presentar su dise?o en el aula universitaria, Reiley se vio obligada a recurrir a la ayuda de un compa?ero de clase, que fue quien transmiti¨® sus ¨®rdenes. ¡°Puede parecer una simple an¨¦cdota¡±, prosigue Reiley en su art¨ªculo, ¡°pero ahora piensen por un momento en un precario hospital de campa?a en un lugar como Afganist¨¢n y en una doctora que pierde a un paciente que podr¨ªa haberse salvado solo porque su avanzado sistema de cirug¨ªa telem¨¢tica depende de una aplicaci¨®n tan rudimentaria y, s¨ª, tan sexista que solo reconoce voces masculinas¡±.

A Reiley le resulta ¡°decepcionante y escandaloso¡± lo poco que se ha progresado en este ¨¢mbito en los ¨²ltimos veinte a?os. ¡°Seguimos sacando al mercado mu?ecas como Hello Barbie, programadas para hablar con ni?as, pero no con ni?os. Nuestros algoritmos de voz o de reconocimiento facial siguen teniendo, casi sin excepci¨®n, un sesgo racial y de g¨¦nero. Y estamos dise?ando nov¨ªsimos sistemas de conducci¨®n aut¨®noma pensados casi exclusivamente por y para hombres blancos¡±.

Reiley ha centrado sus esfuerzos recientes en este ¨²ltimo punto. No pierde de vista, seg¨²n explica, que cuando nos subimos a un veh¨ªculo estamos poniendo nuestra vida en manos de un equipo de seres humanos que ha tomado una serie de decisiones tecnol¨®gicas y de dise?o cruciales. ¡°Si esas personas no han tenido en cuenta nuestras caracter¨ªsticas y necesidades concretas, nos est¨¢n poniendo en peligro¡±.

Llueve sobre mojado. Ya en la d¨¦cada de 1960, cuando la industria automovil¨ªstica desarroll¨® y consolid¨® sus modernos sistemas de seguridad, del cintur¨®n al airbag, se realizaban pruebas con maniqu¨ªes cuyas dimensiones y morfolog¨ªa eran siempre las del hombre medio. El resultado es que todo aquel que no encajase en ese molde predeterminado, empezando por las mujeres, contaba con un nivel de protecci¨®n insuficiente, o al menos sensiblemente inferior al de los hombres. En 2011, cuando por fin empez¨® a consolidarse, por imperativo legal, el uso de maniqu¨ªes femeninos en las pruebas de estr¨¦s y simulacros de colisiones, se comprob¨® que las mujeres llevaban alrededor de cincuenta a?os sufriendo un riesgo de muerte o lesiones graves hasta un 40% superior al de los hombres.

Ni siquiera las pruebas diagn¨®sticas m¨¢s simples y eficaces son ajenas a esta l¨®gica perversa. En una pieza de opini¨®n publicada en The Economist el pasado 10 de abril, se hablaba del sesgo racial de los ox¨ªmetros de pulso, esos sencillos dispositivos que miden la saturaci¨®n de ox¨ªgeno en sangre y han resultado claves para determinar a qui¨¦n se hospitalizaba y a qui¨¦n no en los peores momentos de colapso sanitario causado por la pandemia. La medici¨®n se realiza por contraste crom¨¢tico, proyectando un haz de luz sobre la yema del dedo. Tal y como explica The Economist, dado que lo que se mide es la diferencia entre el color de la sangre y el de la piel, ¡°lo l¨®gico hubiese sido introducir un sistema de calibrado para ajustar la medici¨®n a colores de piel distintos¡±.

Sin embargo, nueve de cada diez ox¨ªmetros homologados no se calibran. De manera que la prueba diagn¨®stica mide de manera muy precisa la saturaci¨®n de ox¨ªgeno de personas de piel blanca, pero tiende a sobrestimar en varios puntos la de los que tienen la piel m¨¢s oscura. Como consecuencia de ello, un alto porcentaje de ciudadanos de piel negra o cobriza con un ¨ªndice de saturaci¨®n real que exigir¨ªa cuidados intensivos no son hospitalizados. Algunos de ellos mueren, v¨ªctimas de unas inercias de dise?o que no tienen en cuenta algo tan elemental como la diversidad racial.

Otro ejemplo. Seg¨²n fuentes de, entre otros, el Texas Heart Institute, el protocolo autom¨¢tico de alertas de salud card¨ªaca sigue sin tener suficientemente en cuenta que los s¨ªntomas de infarto difieren de manera muy significativa en hombres y mujeres. En los hombres se producen de forma recurrente opresi¨®n en la zona del diafragma y un intenso dolor en la mitad izquierda del pecho que irradia al brazo, mientras que en las mujeres son mucho m¨¢s habituales la sudoraci¨®n fr¨ªa, las n¨¢useas o el dolor en espalda, mand¨ªbula y cuello. El Texas Heart Institute denunciaba en 2019 que hoy en d¨ªa se siguen dise?ando dispositivos de asistencia card¨ªaca mediante inteligencia artificial que apenas tienen cuenta estas diferencias, y eso hace que la detecci¨®n precoz resulte mucho m¨¢s probable en hombres que en mujeres.

La periodista Anne Quito, redactora experta en tecnolog¨ªa y dise?o de la revista Quartz, tiene una teor¨ªa: ¡°Ese sesgo que hace que se dise?e pensando en las necesidades espec¨ªficas del hombre blanco joven o de mediana edad se debe a que un porcentaje alt¨ªsimo de los dise?adores encajan en ese retrato robot. Para corregirlo o atenuarlo, bastar¨ªa con contratar a m¨¢s mujeres y a m¨¢s miembros de minor¨ªas raciales¡±. M¨¢s que a prejuicios conscientes, Quito atribuye estas disfunciones a ¡°inercias mentales¡±. Tal y como ella explica, ¡°los neur¨®logos consideran que al menos un 95% por ciento de nuestras decisiones cotidianas se deben a procesos subconscientes que con frecuencia ni siquiera nos cuestionamos o racionalizamos a posteriori¡±.

Entre los desarrolladores de programas de inteligencia artificial existe una m¨¢xima muy com¨²n: ¡°No me hagas pensar¡±. Es decir, se trata de aplicar rutinas y hatajos cognitivos que permitan automatizar y sistematizar las tareas, porque si se aplica una reflexi¨®n consciente sobre cada una de las decisiones de dise?o adaptadas resulta muy dif¨ªcil hacer avances significativos. Esta aproximaci¨®n flexible y pragm¨¢tica permite desarrollar algoritmos de una complejidad extraordinaria, pero no evita que se cometan errores garrafales que no siempre se detectan a tiempo.

Algunos de esos errores pueden resultar c¨®micos. En marzo de 2016, Microsoft lanz¨® Tay, un programa de inteligencia artificial pensado para conversar con el resto de usuarios en Twitter. Se trataba de la adaptaci¨®n al mercado angloparlante de Xiaoice, un bot lanzado a?o y medio antes en redes sociales chinas y que hab¨ªa mantenido m¨¢s de 40 millones de conversaciones con interlocutores humanos sin que se detectasen problemas dignos de menci¨®n. Tay (acr¨®nimo de Thinking About You) estaba dotada de la personalidad, la visi¨®n del mundo y los recursos ling¨¹¨ªsticos de una joven estadounidense de 19 a?os y, adem¨¢s, incorporaba un complejo algoritmo de aprendizaje autom¨¢tico (llamado deep learning) basado en el que utilizan los programas de ajedrez.

Esta inteligencia artificial ¡°c¨¢lida y emp¨¢tica¡±, seg¨²n descripci¨®n de sus creadores, fue retirada de la circulaci¨®n en apenas 16 horas. En ese periodo, Tay ¡°aprendi¨®¡± a comportarse como una adolescente malcriada, lasciva y prejuiciosa, encadenando frases tan incompatibles con cualquier etiqueta online o criterio de correcci¨®n pol¨ªtica como ¡°Barack Obama es el simio que nos gobierna¡±, ¡°Hitler ten¨ªa raz¨®n¡±, ¡°quiero que tengas sexo con mi co?o rob¨®tico¡±, ¡°George W. Bush fue el responsable del 11-M¡±, ¡°odio a los homosexuales¡± o ¡°deseo que todas las feministas se pudran en el infierno¡±. Microsoft atribuy¨® la deriva de su bot, programado para comportarse como ¡°una adolescente cordial, amable y un poco ingenua¡±, al asalto concertado de los usuarios de 4chan, el ForoCoches anglosaj¨®n, un entorno con usuarios muy activos, virulentos en sus interacciones y proclives al sabotaje l¨²dico.

El caso es que Tay fue bautizada por la prensa como ¡°la robot racista y neonazi¡± y fue a parar a las mazmorras de Microsoft, mientras sus programadores buscaban la manera de refinar su algoritmo de autoaprendizaje y blindarlo contra el asalto de trolls maliciosos. El 30 de marzo, el bot reapareci¨® de nuevo apenas unas horas y muy pronto empez¨® a incurrir en comportamientos escandalosos no previstos, como la apolog¨ªa de las drogas. Para Anne Quinto, ¡°lo desconcertante de este caso es que un algoritmo tan refinado como Tay se mostrase tan vulnerable al asalto de los trolls tras superar miles de horas de interacci¨®n simulada que, al menos en teor¨ªa, deber¨ªan haberla preparado para asomarse al mundo real¡±.

Quinto a?ade que ¡°a sus programadores, casi todos hombres blancos, no se les ocurri¨® que pod¨ªa ser v¨ªctima del alto grado de toxicidad de las redes sociales, porque ellos, por mucho que puedan rechazarla, no la sufren en la misma medida que una mujer o el miembro de una minor¨ªa racial o sexual¡±. Microsoft decidi¨® retirar de nuevo a la adolescente descarriada y la sustituy¨® meses despu¨¦s, en diciembre de 2016, por Zo, una conversadora, en principio, tan insulsa y tan neutra, que The Washington Post, lleg¨® a definirla como ¡°una mojigata sin sustancia ni inteligencia cuya principal preocupaci¨®n consiste, al parecer, en re?ir a los interlocutores que expresan opiniones pol¨¦micas¡±. Pese a todo, un redactor de la revista BuzzFeedNews ¡°entrevist¨®¡± a Zo y consigui¨® sacarla en varias ocasiones de su zona de confort, arrastr¨¢ndola a expresar opiniones como que el Cor¨¢n es un libro ¡°violento¡± o que la muerte de fan¨¢ticos como Osama Bin Laden deb¨ªa ser celebrada.

Menci¨®n aparte en esta galer¨ªa de horrores tecnol¨®gicos merecen los sistemas de reconocimiento facial. Tras varios intentos infructuosos, Facebook, Google y Microsoft han decidido retirarse hasta nuevo aviso de este campo potencialmente tan rentable pero tan resbaladizo. Uno de los ¨²ltimos en padecer los rigores del dise?o para hombres blancos ha sido Robert Julian-Borchak Williams, afroamericano residente en los suburbios de Detroit. En enero de 2020, Williams pas¨® casi 20 horas bajo custodia policial despu¨¦s de que un algoritmo de reconocimiento facial le relacionase con el autor del asalto a una tienda de objetos de lujo. De poco sirvi¨® que dos de los agentes que interactuaron con ¨¦l insistiesen a sus superiores en que el arrestado apenas se parec¨ªa al retrato robot del sospechoso, reconstruido a partir de un fotograma poco n¨ªtido de las c¨¢maras de seguridad de la tienda. El algoritmo le identific¨® porque, sencillamente, no estaba programado para distinguir con precisi¨®n a un afroamericano de otro.

Estamos hablando de programas con un grado de optimizaci¨®n tan deficiente que confunden a personas de piel negra con gorilas, como comprob¨® en sus propias carnes Jacky Alcine, dise?ador de software neoyorquino al que Google etiquet¨® en su banco de im¨¢genes como primate en lugar de ser humano. Tanto Alcine como Williams se han embarcado en sendas cruzadas para que dispositivos de funcionamiento tan dudoso no sean utilizados ni en redes sociales ni, por supuesto, en instituciones oficiales como juzgados o departamentos de polic¨ªa.

Hoo Keat Wong, doctor en psicolog¨ªa residente en Malasia, escribi¨® un art¨ªculo sobre el incomprensible sesgo racial de estos programas despu¨¦s de encontrarse en una situaci¨®n absurda un d¨ªa en que acudi¨® a un servicio digital para hacerse fotos para la renovaci¨®n de su pasaporte: el programa daba error y le exhortaba una y otra vez a ¡°abrir los ojos¡±, obviando que Wong, como la mayor¨ªa de los ciudadanos de Asia Oriental, es de ¡°ojos rasgados¡±. Es decir, tiene un muy pronunciado pliegue del epicanto, la arruga del p¨¢rpado superior que cubre el ojo. M¨¢s de un tercio de los habitantes del planeta Tierra comparten ese rasgo. Pero muchos programas de reconocimiento facial, sea por inercias subconscientes o por el etnocentrismo impenitente y desconsiderado de sus creadores, prefieren no tenerlo en cuenta.

Tu suscripci¨®n se est¨¢ usando en otro dispositivo

?Quieres a?adir otro usuario a tu suscripci¨®n?

Si contin¨²as leyendo en este dispositivo, no se podr¨¢ leer en el otro.

FlechaTu suscripci¨®n se est¨¢ usando en otro dispositivo y solo puedes acceder a EL PA?S desde un dispositivo a la vez.

Si quieres compartir tu cuenta, cambia tu suscripci¨®n a la modalidad Premium, as¨ª podr¨¢s a?adir otro usuario. Cada uno acceder¨¢ con su propia cuenta de email, lo que os permitir¨¢ personalizar vuestra experiencia en EL PA?S.

En el caso de no saber qui¨¦n est¨¢ usando tu cuenta, te recomendamos cambiar tu contrase?a aqu¨ª.

Si decides continuar compartiendo tu cuenta, este mensaje se mostrar¨¢ en tu dispositivo y en el de la otra persona que est¨¢ usando tu cuenta de forma indefinida, afectando a tu experiencia de lectura. Puedes consultar aqu¨ª los t¨¦rminos y condiciones de la suscripci¨®n digital.