Google arregla su algoritmo ¡®racista¡¯ borrando a los gorilas

Google Photos confund¨ªa personas negras con simios. Este parche muestra la opacidad de los algoritmos

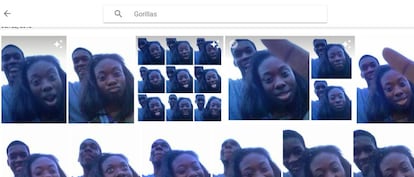

En junio de 2015, un usuario de Google Photos descubri¨® que el programa etiquetaba a sus amigos negros como gorilas. La inteligencia artificial de Google no era capaz de distinguir una tez oscura de humano de la de simios como gorilas y chimpanc¨¦s. Ese sesgo racista de la m¨¢quina oblig¨® a disculparse a Google, que se comprometi¨® a buscar una soluci¨®n al error. Dos a?os despu¨¦s, la soluci¨®n est¨¢ clara: para que el programa no confunda a humanos con gorilas, han sacado a los gorilas del buscador. Y a los chimpanc¨¦s. Y a los monos.

En Wired han hecho la prueba, alimentando a la m¨¢quina con miles de fotos, incluidas las de estos grandes simios y tambi¨¦n de otras especies de monos. El programa ¡ªideado para clasificar las fotos de los usuarios por s¨ª solo, usando inteligencia artificial¡ª responde a la perfecci¨®n cuando le pides que encuentre orangutanes, gibones, babuinos o monos tit¨ª, encontr¨¢ndolos sin problemas. Pero se queda en blanco cuando le preguntas por "monos", "gorilas" y "chimpanc¨¦s", aunque tenga unos cuantos en sus entra?as. El parche de Google es hacer desaparecer estos animales del l¨¦xico de esta aplicaci¨®n para la gesti¨®n de fotos personales (no el buscador de im¨¢genes). El programa tampoco sabe buscar "hombre negro" o "mujer negra".

La forma de solucionar el problema es borrar el problema: autocensurar esas etiquetas. "La tecnolog¨ªa de etiquetado de im¨¢genes todav¨ªa es joven y lamentablemente no es perfecta", respondi¨® un portavoz de Google, admitiendo el parche. Flickr gener¨® un problema similar, al etiquetar a negros como simios. El algoritmo de Facebook permit¨ªa discriminar por su raza a los usuarios. Estos subproductos inesperados est¨¢n por todas partes.

"Los que est¨¢n en grupos hist¨®ricamente marginados ¡ªmujeres, no blancos y menos educados¡ª se muestran como los m¨¢s temerosos ante la tecnolog¨ªa", asegura un estudio

Este episodio es un ejemplo perfecto de algunos de los problemas que se est¨¢n descubriendo en el ¨¢mbito de la inteligencia artificial. Por ejemplo, que los algoritmos heredan sesgos y prejuicios presentes en las bases de datos (alimentadas por humanos) y en las manos de los programadores que los desarrollan. Los innovadores, los inventores, tienden a ser hombres blancos de buena familia, y eso termina asomando de alg¨²n modo en el fruto de su trabajo.

Tambi¨¦n demuestra que la tecnolog¨ªa que permite a las m¨¢quinas el reconocimiento visual es mucho m¨¢s dif¨ªcil de perfeccionar de lo que a veces creemos. Es posible que dentro de poco tengamos coches automatizados circulando por las calles, tomando decisiones dif¨ªciles como a qui¨¦n atropellar. En caso de duda, ?qu¨¦ ocurre si a las m¨¢quinas les cuesta diferenciar a un animal de una persona? ?Elegir¨¢ salvar a la persona de tez m¨¢s clara y atropellar¨¢ a la de piel oscura porque puede ser un mono? "Es muy dif¨ªcil modelar todo lo que ver¨¢ su sistema una vez que est¨¦ en vivo", reconoce Vicente Ord¨®?ez Rom¨¢n, profesor de la Universidad de Virginia, en Wired.

Este incidente ilustra un problema mayor: las m¨¢quinas terminan siendo una caja negra, opaca y llena de secretos, incluso para sus propios desarrolladores

Adem¨¢s, este incidente ilustra un problema mayor sobre el que vienen advirtiendo los expertos en inteligencia artificial: las m¨¢quinas terminan siendo una caja negra, opaca y llena de secretos, incluso para sus propios desarrolladores. El programador sabe con qu¨¦ elementos ha alimentado al algoritmo y sabe cu¨¢les son los resultados, pero no conoce en detalle los procesos que suceden dentro del cerebro de silicio. Cuando algo falla, como en este caso, no saben exactamente por qu¨¦ ni pueden ir directamente a solucionar el problema porque no saben d¨®nde est¨¢.?"Podemos construir estos modelos, pero no sabemos c¨®mo funcionan", reconoc¨ªa un especialista en diagn¨®stico de enfermedades usando inteligencia artificial.

"La toma de decisiones automatizada puede plantear riesgos significativos para los derechos y libertades de las personas que requieren salvaguardias apropiadas", advert¨ªa un informe de AI Now, un instituto dedicado a la investigaci¨®n sobre los problemas derivados del uso de la inteligencia artificial. Ese informe criticaba la opacidad con la que operan esas cajas negras. En algunos casos opacas para sus creadores y por lo general opacas para la sociedad a la que afectan sus decisiones: finanzas, sanidad, seguros, mercado de trabajo, decisiones judiciales... Todos se ven afectados ya por decisiones algor¨ªtmicas.?

Un estudio reciente sobre la percepci¨®n social de los robots mostraba una conclusi¨®n interesante en este contexto: "Los que est¨¢n en grupos hist¨®ricamente marginados ¡ªmujeres, no blancos y menos educados¡ª se muestran como los m¨¢s temerosos ante la tecnolog¨ªa". Seguramente no sea casual.

Tu suscripci¨®n se est¨¢ usando en otro dispositivo

?Quieres a?adir otro usuario a tu suscripci¨®n?

Si contin¨²as leyendo en este dispositivo, no se podr¨¢ leer en el otro.

FlechaTu suscripci¨®n se est¨¢ usando en otro dispositivo y solo puedes acceder a EL PA?S desde un dispositivo a la vez.

Si quieres compartir tu cuenta, cambia tu suscripci¨®n a la modalidad Premium, as¨ª podr¨¢s a?adir otro usuario. Cada uno acceder¨¢ con su propia cuenta de email, lo que os permitir¨¢ personalizar vuestra experiencia en EL PA?S.

En el caso de no saber qui¨¦n est¨¢ usando tu cuenta, te recomendamos cambiar tu contrase?a aqu¨ª.

Si decides continuar compartiendo tu cuenta, este mensaje se mostrar¨¢ en tu dispositivo y en el de la otra persona que est¨¢ usando tu cuenta de forma indefinida, afectando a tu experiencia de lectura. Puedes consultar aqu¨ª los t¨¦rminos y condiciones de la suscripci¨®n digital.

Sobre la firma