Por qu¨¦ los impulsores de la inteligencia artificial firman tantos manifiestos apocal¨ªpticos

Los creadores de esta tecnolog¨ªa, sus principales inversores y miles de acad¨¦micos han alertado de peligros extraordinarios en las ¨²ltimas semanas

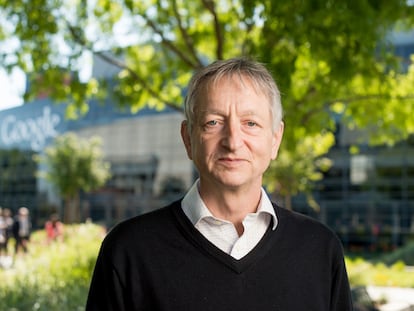

Por si el mundo no ten¨ªa ya una variedad de opciones futuras de calamidad total, ahora tenemos otra nueva: la inteligencia artificial. En solo dos meses, miles de expertos han pedido que se pause, se observe y se regule. Primero fueron m¨¢s de 30.000 personas encabezadas por Elon Musk, cofundador de Tesla, y Steve Wozniak, cofundador de Apple, quienes pidieron en marzo que se detuviera seis meses la investigaci¨®n en inteligencia artificial (IA). Luego, uno de los padres de estos desarrollos, Geoffrey Hinton, dej¨® Google para advertir sobre sus posibles tinieblas; poco despu¨¦s, Sam Altman, l¨ªder de la empresa que ha creado el producto m¨¢s exitoso en este campo, ChatGPT, fue al Congreso a decir que ¡°todo puede salir muy mal¡±, y ahora est¨¢ de gira por el mundo para, entre otras cosas, advertir de peligros ¨¦picos.

Por si este arsenal fuera poco, el martes se public¨® otro manifiesto de solo 22 palabras en su original ingl¨¦s: ¡°Mitigar el riesgo de extinci¨®n de la IA deber¨ªa ser una prioridad mundial junto con otros riesgos a escala social, como las pandemias y la guerra nuclear¡±, dec¨ªa. Firmado por 350 personas, los dos primeros firmantes son precisamente Hinton y Yoshua Bengio, dos galardonados en 2018 con el Premio Turing, el ¡°Nobel¡± de la inform¨¢tica, por ser ¡°padres¡± de la revoluci¨®n de la IA. Otros tres ilustres firmantes son los tres l¨ªderes de las principales empresas de IA hoy: Altman, de OpenAI; Demis Hassabis, de DeepMind (propiedad de Google); y Daniel Amodei, de Anthropic.

1. ?Qu¨¦ hay que regular?

?Por qu¨¦ toda esta grandilocuencia repentina en contra de algo espectral y desconocido a¨²n? Hay varias respuestas, unas m¨¢s sinceras, otras m¨¢s c¨ªnicas. Primero, es destacable que haya uno de los tres padres de la IA que no firmara. Junto a Hinton y Bengio, tambi¨¦n obtuvo en 2018 el Premio Turing el franc¨¦s Yann LeCun, que lleva varios d¨ªas explicando en Twitter por qu¨¦ no est¨¢ en el bando del temor existencial: su hip¨®tesis es que es dif¨ªcil regular algo que no sabemos c¨®mo ser¨¢, dice.

¡°La IA superhumana no est¨¢ ni cerca de la parte alta en la lista de riesgos existenciales. En gran medida porque a¨²n no existe. Hasta que tengamos un dise?o b¨¢sico para la IA nivel perro (por no hablar de nivel humano), discutir c¨®mo hacerla segura es prematuro¡±, escribi¨® en Twitter. En una charla reciente, LeCun us¨® esta met¨¢fora: ¡°?C¨®mo puedes dise?ar cinturones para un coche si el coche no existe a¨²n?¡±

Super-human AI is nowhere near the top of the list of existential risks.

— Yann LeCun (@ylecun) May 30, 2023

In large part because it doesn't exist yet.

Until we have a basic design for even dog-level AI (let alone human level), discussing how to make it safe is premature. https://t.co/ClkZxfofV9

Esa ignorancia sobre el futuro no es algo que solo piense LeCun. El propio Altman cree que para que haya un salto real en la capacidad de la IA, deben ocurrir cosas de las que no se tiene ni idea: ¡°Un sistema que no puede aportar a la suma del conocimiento cient¨ªfico, descubrir nueva ciencia fundamental, no es una superinteligencia. Y para hacerlo bien, tendremos que expandir el modelo GPT de maneras bastante importantes para las que todav¨ªa nos faltan ideas. No s¨¦ cu¨¢les son esas ideas. Estamos tratando de encontrarlas¡±, dijo en una entrevista reciente.

Esta grandilocuencia existencial otorga a la IA una capacidad que a¨²n no sabemos si tiene.

2. Por qu¨¦ m¨¢s manifiestos

Si hubo un manifiesto en marzo, ?por qu¨¦ necesitamos otro? La diferencia del manifiesto breve de esta semana es claramente que este ¨²ltimo lo firman los l¨ªderes de la industria. Altman (OpenAi), Hassabis (Google), Amodei (Anthropic) y Hinton (ex Google) no firmaron el primero, que ped¨ªa una moratoria en el desarrollo de estos programas: evidentemente, estas compa?¨ªas no quieren pausar la investigaci¨®n. El resto de los firmantes lo forman una peque?a parte de los que ya apoyaron el manifiesto original de marzo, que ya son m¨¢s de 31.000 personas, principalmente acad¨¦micos. Sus promotores, del Future of Life Institute, mandaron un correo electr¨®nico el 19 de mayo a sus firmantes para que de nuevo se ¡°unieran a Hinton, Bengio y Amodei¡± porque es ¡°esencial normalizar y legitimar el debate sobre los riesgos m¨¢s graves de la IA¡±.

3. ?Una cortina de humo?

Unos d¨ªas antes del manifiesto breve, Altman public¨® junto a otros dos dirigentes de OpenAI un art¨ªculo titulado Gobernanza de la superinteligencia. All¨ª ped¨ªan despreocuparse de los modelos actuales para centrarse en legislar sobre el peligro futuro: ¡°Los sistemas de hoy crear¨¢n un enorme valor en el mundo y, si bien tienen riesgos, el nivel de esos riesgos es acorde con otras tecnolog¨ªas de internet. Al contrario, los sistemas que nos preocupan tendr¨¢n un poder m¨¢s all¨¢ de cualquier tecnolog¨ªa creada hasta ahora¡±.

En Londres, durante su gira europea, Altman dijo que se plantear¨ªan retirar ChatGPT del continente si la Uni¨®n Europea avanza en su ¡°sobrerregulaci¨®n¡±, que debatir¨¢n en un pleno del Parlamento el d¨ªa 13. Una opci¨®n legislativa es la de obligar a las empresas con modelos como ChatGPT a revelar los datos con copyright en el corpus con el que entrenan sus m¨¢quinas, un escenario conflictivo. D¨ªas despu¨¦s, el l¨ªder de OpenAI tuite¨® que ya no se planteaban abandonar Europa. Ahora, incluso parece que buscan sede europea, seg¨²n se ha publicado.

As¨ª, una posible explicaci¨®n tras los manifiestos es que empresas como OpenAI prefieren que los pol¨ªticos debatan sobre apocal¨ªpticos riesgos existenciales futuros, en lugar de centrarse en leyes que puedan complicar su expansi¨®n hoy.

Watermarking, external audits, feedback loops - just some of the ideas discussed with @AnthropicAI and @sama @OpenAI for the #AI #CodeOfConduct launched today at the #TTC in #Lule? @SecRaimondo Looking forward to discussing with international partners. pic.twitter.com/wV08KDNs3h

— Margrethe Vestager (@vestager) May 31, 2023

Con estas amenazas, Altman se asegura tambi¨¦n ser consultado cuando llegue el momento de proponer leyes. Si los legisladores ven estos modelos como algo incomprensible, requerir¨¢n de la ayuda de los ¡°expertos¡± dentro de las empresas para regular, dice Jake Browning, investigador de la Universidad de Nueva York sobre la filosof¨ªa de la IA y que no ha firmado el manifiesto. Precisamente, la comisaria europea de Competencia, Margrethe Vestager, hizo p¨²blica esta semana sus reuniones con Altman y Amodei justo despu¨¦s de anunciar su inminente propuesta de ¡°c¨®digo de conducta voluntario¡±. Un d¨ªa despu¨¦s, se reuni¨® con la presidenta de la Comisi¨®n, Ursula von der Leyen.

Bruselas est¨¢ m¨¢s enfocada al aqu¨ª y ahora: ¡°La UE es una amenaza [para estas empresas] porque ignora la exageraci¨®n de la IA y solo observa las consecuencias, tratando estos nuevos modelos como servicios¡±, dice Browning. Y se pregunta: ¡°?Es fiable la informaci¨®n proporcionada por GPT? ?Cumplen las normas de privacidad existentes, como el derecho al olvido? ?Respetan los derechos de autor? ?La b¨²squeda de IA de Google conducir¨¢ a monopolios? ?Las empresas comercializan estos productos con honestidad? En todas esas m¨¦tricas, estos modelos de lenguaje salen mal: son propensos a alucinar; entrenan y reproducen datos privados; no respetan las leyes de derechos de autor; est¨¢n dise?ados para afianzar el poder de las grandes tecnolog¨ªas y aumentar sus ingresos publicitarios, y se comercializan de manera enga?osa sin la debida advertencia sobre sus limitaciones¡±.

4. El cuento del fin del mundo

El fin del mundo es un debate que genera gran inter¨¦s en Silicon Valley. El propio Altman ha dicho que debemos pensar m¨¢s en la extinci¨®n de los humanos. Pero los cr¨ªticos con estos manifiestos exagerados creen que entre las prioridades de sus c¨¦lebres firmantes no est¨¢ la de beneficiar a la humanidad. Timnit Gebru, experta en ¨¦tica computacional de la Universidad de Stanford, alert¨® antes de esta explosi¨®n de los sesgos y peligros de estos modelos. No solo no le hicieron caso, sino que Google la despidi¨®.

Hoy Gebru sigue viendo solo hipocres¨ªa en este debate sobre la impredecible superinteligencia del futuro: ¡°Esto es un movimiento que lleva d¨¦cadas en construcci¨®n, con los mismos financiadores multimillonarios de OpenAI, Deepmind y ahora Anthropic. Su padre ideol¨®gico, Nick Bostrom [autor del best seller Superinteligencia], habla de ¡®presiones disg¨¦nicas¡¯, que es que aquellos considerados est¨²pidos se reproduzcan demasiado, lo que ser¨ªa un riesgo existencial para la humanidad, y dijo que ¡®los negros son m¨¢s est¨²pidos que los blancos¡¯ y nos insult¨®. ?Quieren que creamos que son ellos los que se preocupan por la humanidad? ?D¨®nde estaban cuando nosotras creamos conciencia sobre los da?os reales y nos enfrentamos a una reacci¨®n violenta? Es casi como un ataque inform¨¢tico coordinado para que nos distraigamos de responsabilizar a las verdaderas organizaciones que causan da?o¡±.

To co-sign, retweet: pic.twitter.com/r6lLLqYSP6

— @emilymbender@dair-community.social on Mastodon (@emilymbender) May 30, 2023

?mile Torres, de la Universidad Leibniz de Hannover, lleva a?os estudiando estas teor¨ªas de la aniquilaci¨®n futura: ¡°Se pone mucho el foco en la IA, pero no tanto en las empresas de IA. Esta atenci¨®n da a las compa?¨ªas una especie de v¨ªa libre. Redirige la mirada de lo que est¨¢n haciendo a esta especie de mente misteriosa y extraterrestre que surgir¨¢ por alg¨²n tipo de ley del progreso tecnol¨®gico¡±. Y a?ade: ¡°Esta visi¨®n ut¨®pica fue inventada por un pu?ado de tipos blancos ricos superprivilegiados y ahora tratan de imponerla al resto del mundo¡±. Para ellos, tambi¨¦n llamados transhumanistas, ser¨ªa necesario un cerebro m¨¢s privilegiado que el humano para sobrevivir, es decir, el digital.

5. ?Y si es verdad?

Junto a estas posibles razones, no hay que obviar el motivo m¨¢s expl¨ªcito para apoyar estos manifiestos: creer de verdad que la inteligencia artificial supone un peligro existencial. Que los firmantes, aunque un buen pu?ado tenga intereses econ¨®micos obvios, temen sinceramente un fin del mundo provocado por una IA mal gestionada.

Hay miles de investigadores de docenas de disciplinas, sin v¨ªnculos con la industria, que creen que hay que pausar la investigaci¨®n y vigilar sus riesgos existenciales. EL PA?S ha preguntado sus motivos a 10 acad¨¦micos firmantes de ¨¢mbitos dispares, desde la f¨ªsica y la inform¨¢tica al derecho, la econom¨ªa o la psicolog¨ªa. Sus respuestas pueden englobarse en cuatro puntos:

a) La rapidez del desarrollo. Para quien no estuviera dentro del sector de la IA, la velocidad de la innovaci¨®n es inconcebible. Es quiz¨¢ el temor b¨¢sico: ¡°No hace tanto, el peligro de que las m¨¢quinas representaran un riesgo de extinci¨®n parec¨ªa fantasioso¡±, se?ala Andrew Briggs, catedr¨¢tico em¨¦rito de Nanomateriales de la Universidad de Oxford. ¡°El ritmo del progreso en la IA ahora acelera tan r¨¢pido, como lo muestran motores como ChatGPT, que se ha vuelto urgente buscar medidas de seguridad antes de que sea tarde¡±, a?ade.

La velocidad puede traer problemas imprevistos, como dice Juan Pav¨®n, catedr¨¢tico de Ingenier¨ªa del Software e IA de la Universidad Complutense: ¡°Se est¨¢ avanzando m¨¢s r¨¢pido en el desarrollo de grandes modelos de IA que en su comprensi¨®n, y como se trata de sistemas complejos, con multitud de interacciones entre los elementos que los componen, pueden producirse efectos no deseados e imprevistos¡±, dice.

b) Ignorancia sobre c¨®mo funcionan. El desconocimiento es otro factor que preocupa a los firmantes. ¡°Los programas de IA como GPT4 y sus probables sucesores son sistemas extremadamente complejos, y realmente no los entendemos¡±, asegura Alessandro Saffiotti, catedr¨¢tico de Ciencias de la Computaci¨®n de la Universidad de ?rebro (Suecia). ¡°Aun as¨ª, podr¨ªamos terminar deleg¨¢ndoles decisiones cr¨ªticas para el planeta y nuestra sociedad: centrales el¨¦ctricas, transacciones financieras o incluso sistemas militares. Si las empresas no hacen una pausa en el despliegue de esos sistemas hasta que los entendamos mejor, debemos ir prepar¨¢ndonos para posibles escenarios desastrosos¡±.

¡°Se trata de ¡®lo que no sabemos que no sabemos¡¯, es decir, el potencial de problemas graves que pueden surgir de una manera imprevista¡±, advierte Henning Grosse Ruse-Khan, profesor de Derecho de la Universidad de Cambridge. Y apunta: ¡°El potencial de la IA es tan significativo que no tenemos una manera realista de predecir, ni siquiera adivinar, sus consecuencias¡±.

c) La duda obliga a la prudencia. La frase de 22 palabras del ¨²ltimo manifiesto es f¨¢cil de asumir por mero an¨¢lisis de riesgos. El texto viene a decir: si tienes una pistola cargada con 3 balas en un cargador de 100, ?disparar¨ªas? Aunque no sepamos si esa pistola existe, la respuesta natural es intentar sacar esas 3 balas del cargador. ¡°Es importante hablarlo debido a la gran incertidumbre que hay¡±, dice Edoardo Gallo, profesor de Econom¨ªa de la Universidad de Cambridge. ¡°Tenemos muy poca idea de las probabilidades. Estoy bastante seguro de que el riesgo de extinci¨®n de la IA en los pr¨®ximos 100 a?os es muy peque?o, pero tambi¨¦n estoy bastante seguro de que no es cero¡±, a?ade.

Al final, el debate se reduce a una apuesta. Browning, que no firm¨®, est¨¢ c¨®modo negando todos los riesgos. ¡°Si crees que el lenguaje es el n¨²cleo de la inteligencia, puedes inclinarte a pensar que una m¨¢quina parlante as¨ª est¨¢ a un paso de distancia de la inteligencia superhumana¡±, explica. Pero ¨¦l no cree que sea as¨ª: ¡°Filos¨®ficamente, no creo que la superinteligencia tenga sentido como concepto; t¨¦cnicamente, no creo que nada que suceda bajo la etiqueta de ¡®IA¡¯, sin importar c¨®mo de amplia sea, represente una amenaza existencial¡±.

En esa duda, Bojan Arbutina, profesor de Astrof¨ªsica de la Universidad de Belgrado, prefiere equivocarse por exceso: ¡°Puede que la amenaza sea exagerada, pero si no lo es, no tendremos tiempo de reconsiderarlo, y por tanto, creo que debe tomarse en serio. No podemos comprender todos los riesgos. La superinteligencia podr¨ªa, por ejemplo, percibirnos a los humanos como nosotros vemos a los insectos o incluso a las bacterias¡±, afirma.

d) Hay muchos otros problemas. Pero no hay que ir tan lejos, dice Helena Matute, catedr¨¢tica de Psicolog¨ªa de Deusto, que pide que ¡°no se mezcle el riesgo existencial con la discusi¨®n sobre la consciencia y la inteligencia, no tiene nada que ver¡±. Para Matute, el n¨²mero de desaf¨ªos de la humanidad no debe ser una excusa para no fijarnos en la IA: ¡°Limitar la discusi¨®n solo a los riesgos que algunos consideran ya obvios es ir por detr¨¢s del problema. Hay que llegar pronto a acuerdos mundiales que minimicen los riesgos de la IA, todos los riesgos. No entiendo por qu¨¦ algunos creen tener una especie de venia para decir: ¡®Esto se puede regular, pero esto no¡±.

Estos expertos tambi¨¦n incluyen la regulaci¨®n inmediata y actual, que otras partes con intereses econ¨®micos pueden despreciar: ¡°Mi objetivo, al destacar las amenazas existenciales de la IA, es exactamente lo contrario de tratar de descartar los da?os a corto plazo¡±, dice Michael Osborne, profesor de IA en la Universidad de Oxford. Y asegura: ¡°En cambio, deseo enfatizar que no estamos haciendo lo suficiente para gobernar la IA, una tecnolog¨ªa que hoy en d¨ªa est¨¢ estrictamente controlada por un peque?o n¨²mero de empresas tecnol¨®gicas opacas y poderosas¡±.

Puedes seguir a EL PA?S Tecnolog¨ªa en Facebook y Twitter o apuntarte aqu¨ª para recibir nuestra newsletter semanal.

Tu suscripci¨®n se est¨¢ usando en otro dispositivo

?Quieres a?adir otro usuario a tu suscripci¨®n?

Si contin¨²as leyendo en este dispositivo, no se podr¨¢ leer en el otro.

FlechaTu suscripci¨®n se est¨¢ usando en otro dispositivo y solo puedes acceder a EL PA?S desde un dispositivo a la vez.

Si quieres compartir tu cuenta, cambia tu suscripci¨®n a la modalidad Premium, as¨ª podr¨¢s a?adir otro usuario. Cada uno acceder¨¢ con su propia cuenta de email, lo que os permitir¨¢ personalizar vuestra experiencia en EL PA?S.

?Tienes una suscripci¨®n de empresa? Accede aqu¨ª para contratar m¨¢s cuentas.

En el caso de no saber qui¨¦n est¨¢ usando tu cuenta, te recomendamos cambiar tu contrase?a aqu¨ª.

Si decides continuar compartiendo tu cuenta, este mensaje se mostrar¨¢ en tu dispositivo y en el de la otra persona que est¨¢ usando tu cuenta de forma indefinida, afectando a tu experiencia de lectura. Puedes consultar aqu¨ª los t¨¦rminos y condiciones de la suscripci¨®n digital.

Sobre la firma