La m¨¢quina de la moral y otras ideas para que los coches tomen decisiones correctas

Una m¨¢quina de la moral y fil¨®sofos colaboran con el MIT para ense?ar a los coches a resolver un accidente con el menor n¨²mero de v¨ªctimas posible

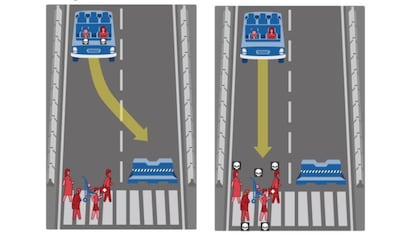

De entre todas las dudas que suscitan los coches aut¨®nomos, las que tienen que ver con su capacidad para tomar decisiones son las que m¨¢s debate generan. Muchos usuarios a¨²n temen que el coche pueda cometer un error y estrellarse. Pero lo cierto es que se equivocan mucho menos que los conductores humanos y que el drama real puede venir porque el coche tome la decisi¨®n de estrellarse y sacrificar a los pasajeros. Visto as¨ª parece parte de la trama de La rebeli¨®n de las m¨¢quinas, pero es algo que podr¨ªa suceder en una situaci¨®n en la que el da?o fuera inevitable y el coche tuviera que decidir entre atropellar a tres peatones o estrellarse y da?ar a un pasajero. Es como el dilema de accionar una palanca para que un tren arrolle a una persona o no accionarla y dejar que arrolle a cinco. Pero en la vida real. En este escenario, ?qui¨¦n ense?a a las m¨¢quinas a elegir? ?Qui¨¦n decide qu¨¦ es m¨¢s correcto en cada situaci¨®n?

- La m¨¢quina de la moral

El Instituto Tecnol¨®gico de Massachusetts (MIT) trabaja con una m¨¢quina de la moral a la que han llamado Moral Machine. Es un sistema de inteligencia artificial que presenta distintos escenarios en los que los coches tienen que tomar decisiones a la hora de resolver un accidente con el menor n¨²mero de v¨ªctimas posible. En estas situaciones se asume que frenar y evitar la colisi¨®n no es una opci¨®n: se trata de casos en los que el autom¨®vil est¨¢ 100% seguro de que alguien sufrir¨¢ da?o pero puede actuar para seleccionar qui¨¦n lo sufrir¨¢.

Las situaciones se presentan en una p¨¢gina web donde cualquier persona puede jugar a decidir qu¨¦ cree que deber¨ªa hacer el coche en cada uno de los ejemplos. Los datos recogidos pasan a formar parte de un estudio sobre la ¨¦tica de las m¨¢quinas aut¨®nomas elaborado por cient¨ªficos del MIT Media Lab. En este caso, se est¨¢n utilizando decisiones de la mayor¨ªa de las personas que participan para estudiar c¨®mo los humanos creen que se deber¨ªan programar los coches aut¨®nomos. La inteligencia artificial se convierte una vez m¨¢s en un reflejo de nuestras decisiones humanas.

A trav¨¦s de distintas preguntas, los investigadores tratan de establecer cu¨¢l ser¨ªa el comportamiento m¨¢s adecuado que deber¨ªa tener un coche sin conductor desde un punto de vista moral para la mayor¨ªa. Analizando los resultados, los responsables han detectado que "casi por unanimidad la gente quiere coches que minimicen los da?os totales". As¨ª lo explicaba Iyad Rahwan, director de Scalable Cooperation en el MIT Media Lab, en una entrevista para Vodafone One.

Pero a¨²n minimiz¨¢ndose los da?os, ?qui¨¦n debe salvarse con m¨¢s prioridad? ?Qui¨¦n ha respetado las se?ales de tr¨¢fico? ?Los m¨¢s j¨®venes? ?Los m¨¢s sanos? ?Un m¨¦dico frente a un ladr¨®n? ?Podr¨¢n los coches llegar a detectar si una mujer est¨¢ embarazada o a qu¨¦ se dedican los transe¨²ntes? Los expertos no se atreven a vaticinarlo pero todo apunta a que esta tecnolog¨ªa est¨¢ m¨¢s limitada por las cuestiones morales que por sus posibilidades de desarrollo.

- Tambi¨¦n los fil¨®sofos

En colaboraci¨®n con el MIT, los especialistas en ¨¦tica y fil¨®sofos han encontrado un nicho en el que contribuir a la programaci¨®n de las m¨¢quinas. Ya en 2015 se organiz¨® un congreso en la Universidad de Stanford ¡ªuno de los puntos calientes en los que se est¨¢n realizando estos debates¡ª para reunir a ingenieros y fil¨®sofos y debatir sobre la naturaleza de las decisiones de los coches aut¨®nomos. Implementaron distintas configuraciones ¨¦ticas dentro del software que controla los veh¨ªculos aut¨®nomos y luego probaron el c¨®digo en simulaciones e incluso en veh¨ªculos reales.

Mientras que algunos trabajan en ense?ar a pensar a las m¨¢quinas, otros defienden que los coches sin conductor no deber¨ªan tomar decisiones sobre la vida o la muerte, esa es al menos la teor¨ªa que defiende el fil¨®sofo Wendell Wallach, autor de A dangerous master: how to keep technology from slipping beyond our control. Seg¨²n Wallach, asumir que los coches deber¨ªan tomar estas decisiones implica aceptar que pueden sustituirnos como agentes morales. Aunque es cierto que su procesador puede analizar los datos de la situaci¨®n en mil¨¦simas de segundo y tomar una decisi¨®n, las m¨¢quinas carecen de empat¨ªa y de la capacidad de captar matices.

- El verdadero dilema

M¨¢s all¨¢ de las decisiones que debe tomar el coche, los pasajeros deben plantearse una cuesti¨®n fundamental: ?te montar¨ªas en un coche que, llegado el momento, elegir¨ªa estrellarse y sacrificarte? La respuesta de la mayor¨ªa fue la primera que te viene a la mente: ?no! Iyad Rahwan lo explica: "El problema viene cuando les preguntamos si comprar¨ªan ese coche. Su reacci¨®n fue: nunca comprar¨ªa un coche que me pudiera hacer da?o a m¨ª bajo ninguna circunstancia". Y Alfonso Rodr¨ªguez-Pat¨®n, profesor de la Universidad Polit¨¦cnica de Madrid, est¨¢ de acuerdo: "La mayor¨ªa de los ciudadanos van a querer que su coche les salve primero a ellos", explica. "Piensan: "que mi coche sea seguro pero para m¨ª primero".

Pero probablemente en un futuro se regule el comportamiento ¨¦tico de los coches totalmente aut¨®nomos alcanzando alg¨²n tipo de consenso ¨¦tico. "Si no, cada fabricante podr¨¢ resolver estos dilemas de diferente manera", a?ade Rodr¨ªguez-Pat¨®n. Tambi¨¦n se?ala que ser¨¢ dif¨ªcil llegar a programar el comportamiento perfecto en todos los potenciales casos no anticipados o previstos. "Muchas de estas cuestiones no est¨¢n todav¨ªa ni mucho menos resueltas e implican dilemas muy complejos. Que se preparen las compa?¨ªas de seguros y los abogados".

Tu suscripci¨®n se est¨¢ usando en otro dispositivo

?Quieres a?adir otro usuario a tu suscripci¨®n?

Si contin¨²as leyendo en este dispositivo, no se podr¨¢ leer en el otro.

FlechaTu suscripci¨®n se est¨¢ usando en otro dispositivo y solo puedes acceder a EL PA?S desde un dispositivo a la vez.

Si quieres compartir tu cuenta, cambia tu suscripci¨®n a la modalidad Premium, as¨ª podr¨¢s a?adir otro usuario. Cada uno acceder¨¢ con su propia cuenta de email, lo que os permitir¨¢ personalizar vuestra experiencia en EL PA?S.

En el caso de no saber qui¨¦n est¨¢ usando tu cuenta, te recomendamos cambiar tu contrase?a aqu¨ª.

Si decides continuar compartiendo tu cuenta, este mensaje se mostrar¨¢ en tu dispositivo y en el de la otra persona que est¨¢ usando tu cuenta de forma indefinida, afectando a tu experiencia de lectura. Puedes consultar aqu¨ª los t¨¦rminos y condiciones de la suscripci¨®n digital.